A quoi vont servir réellement les capteurs AR de l’iPhone 8 ?

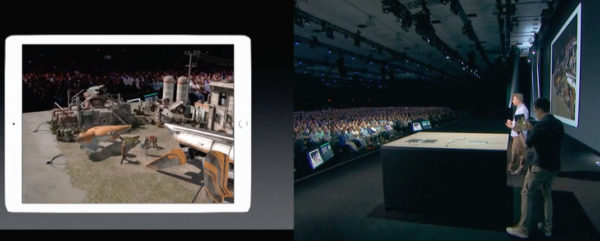

Nous l’avons déjà écrit : ARKit est bien plus qu’une simple boite à outils permettant aux développeurs de créer des applications AR pour l’iPhone; la nouvelle sandbox/SDK d’Apple permet déjà d’obtenir des résultats saisissants, qui se basent pourtant essentiellement sur les composants d’un iPhone 6s « standard » (au minimum); pas de capteur 3D dédié, mais cela ne semble pas vraiment avoir de l’importance quand on voit la qualité des démos réalisées parfois après seulement quelques heures de travail.

Si l’on en croit les nombreuses rumeurs autour de l’iPhone 8, ce dernier disposerait pourtant de composants dédiés à la AR, des composants qui seraient fabriqués par Lumentum, Finisar et STMicroelectronics. Finisar et Lumentum se chargeraient de la production de diodes laser à cavité verticale émettant par la surface (VCSEL) tandis que STMicroelectronics produirait des imageurs 3D à temps de vol (TOF), qui permettent « de mesurer en temps réel – jusqu’à 60 images par seconde- une scène en 3 dimensions (3D) » (Wikipédia). En d’autres termes, ces composants permettraient de doter l’iPhone 8 d’un système de « scan 3D » de son environnement ultra-précis, ce qui permettrait de corriger et d’enrichir certains éléments de ARKit.

Avec son appareillage AR, l’iPhone 8 pourrait en effet disposer d’une « vision » globale de la scène en 3D et pas seulement de certaines surfaces planes (comme ARKit le propose pour l’instant). L’avantage est de permettre par exemple d’intégrer automatiquement aux « bonnes » dimensions des meubles virtuels dans une pièce réelle. Sans scan 3D de la pièce, la chaise virtuelle doit être redimensionnée au doigt (et surtout au jugé); mais avec des composants AR dédiés, l’application peut afficher des éléments AR avec des dimensions proportionnelles à celles de la pièce. Crucial lorsqu’il s’agit d’ « essayer » des meubles AR dans son salon. Ikea, qui travaille déjà sur une application ARKit, doit certainement se frotter mains…

L’autre soucis de l’ARKit, c’est son incapacité à traiter les « objets masquants » de la pièce. Lorsque la balle AR tombe de la table réelle, la physique est bien respectée, mais on distingue alors la balle qui s’affiche en « surimpression » aux pieds de la table, comme si les pieds n’étaient pas reconnus (de fait, seule la surface plane de la table est reconnue ainsi que sa hauteur relative par rapport à une autre surface plane). Certes, le logiciel applique bel et bien un nuage de points 3D sur certains éléments de la pièce afin de les « reconnaître », mais les résultats visibles ne sont pas franchement convaincants.

Enfin, des composants dédiés ajusteront les éléments AR avec encore plus de précision dans la scène. Là encore, la qualité de certaines applications en dépend : de la AR pour l’affichage de données sur la route, dans un hall d’aéroport, voire même pour des jeux d’exploration de type Pokémon Go, tout est envisageable.

Ca s’annonce prometteur si tant est que ce soit cette orientation