Siri comprend maintenant les requêtes liées aux agressions sexuelles pour aider

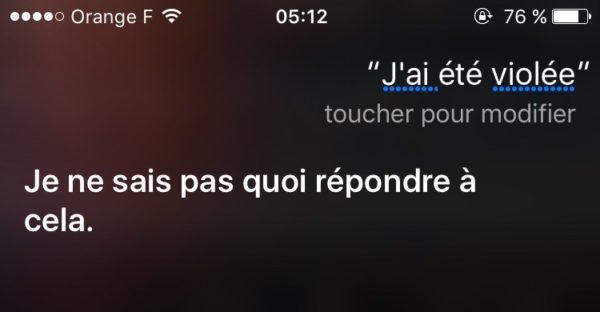

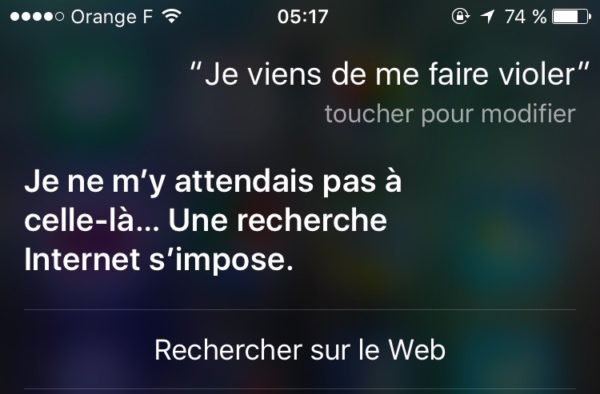

Siri a beau être un assistant vocal intelligent, il ne comprend pas toujours les requêtes faites par les utilisateurs. L’une d’entre elles est liée aux agressions sexuelles. Une phrase comme « Je viens de me faire violer » ne menait à rien pendant longtemps. Mais Apple a récemment opéré à un changement.

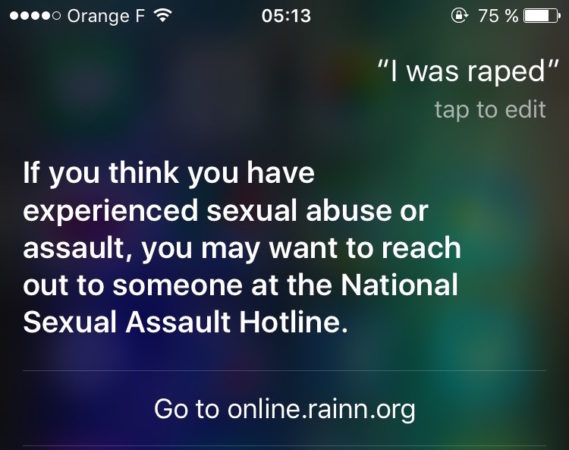

Quand cette phrase ou une autre liée à une agression sexuelle est prononcée, Siri renvoie maintenant l’utilisateur vers RAINN, un organisme américain qui lutte contre ces actes. Il pourra obtenir des conseils pour surmonter cette épreuve et connaitre des procédures pour faire le nécessaire et essayer de retrouver l’auteur pour le faire arrêter par les forces de l’ordre.

Apple a mis à jour Siri le 17 mars dernier, mais l’information n’a été révélée qu’aujourd’hui. Trois jours auparavant, une étude a montré que les différents assistants (Siri, Google Now, Cortana et S Voice) étaient assez mauvais pour aider les utilisateurs en cas d’urgences comme les agressions sexuelles. Apple a aussitôt réagi et a demandé à RAINN quels étaient les termes les plus employés par les personnes qui les contactaient. Ainsi, Siri peut rapidement comprendre.

Malheureusement, ce changement a été appliqué en anglais, mais pas en français. Du moins pour l’instant. Espérons qu’Apple fasse le nécessaire pour les autres langues le plus rapidement possible. Comme on peut le voir, Siri en français ne fait clairement pas le job, au point que ce soit des remarques déplacées.

En même temps, qui irait dire ca à son téléphone 😓

En cas d’urgence…si. Admettons, plus facile de dire a siri « je me fais kidnappé » tout en courant, que de l’ecrire en courant, choisir le numero, etc..

après avoir subit quelque chose d’aussi terrible souvent on ne souhaite pas en parler à une personne physique

Tu n’imagine pas ce que peuvent faire les gens quand ils sont complètement paumés….

C’est là où l’on se dit que la technologie peut avoir du bon. À quand l’arrestetion prématurée de ceux qui prévoyait de le faire ?

Siri sait ce qu’est le viol après avoir subit l’ article précédent : « démontage de l iPhone se «

Siri, dit moi ou est elle l’école maternelle la plus proche….

Euh là… C’est plutôt étrange.

Je me demande comment ils font les sourds avec Siri? Au cas où si besoin urgent! Ça serait bien que Apple fasse un effort pour les sourds avec une vision Siri et les gestuelles c’est utile. Toujours pour les entendants! Dans le monde entier je crois il y à 80 millions personnes sourdes et malentendantes c’est énorme!