Apple dévoile les fonctions d’accessibilité d’iOS 19, de macOS 16 et autres

Apple a dévoilé une série de nouvelles fonctionnalités d’accessibilité qui arriveront dans les mois à venir sur iPhone avec iOS 19, iPad avec iPadOS 19, Mac avec macOS 16, Apple Watch avec watchOS 12 et Apple Vision Pro avec visionOS 3. Cela vient renforcer son engagement historique en faveur de l’inclusion. Cette annonce s’inscrit dans la lignée des efforts déjà bien établis de l’entreprise pour rendre ses produits accessibles à tous.

« Chez Apple, l’accessibilité fait partie de notre ADN », déclare Tim Cook, patron de la firme. « Mettre la technologie à la portée de tous est une priorité pour nous tous et nous sommes fiers des innovations que nous partageons cette année. Cela inclut des outils qui aident les gens à accéder à des informations cruciales, à explorer le monde qui les entoure et à faire ce qu’ils aiment ».

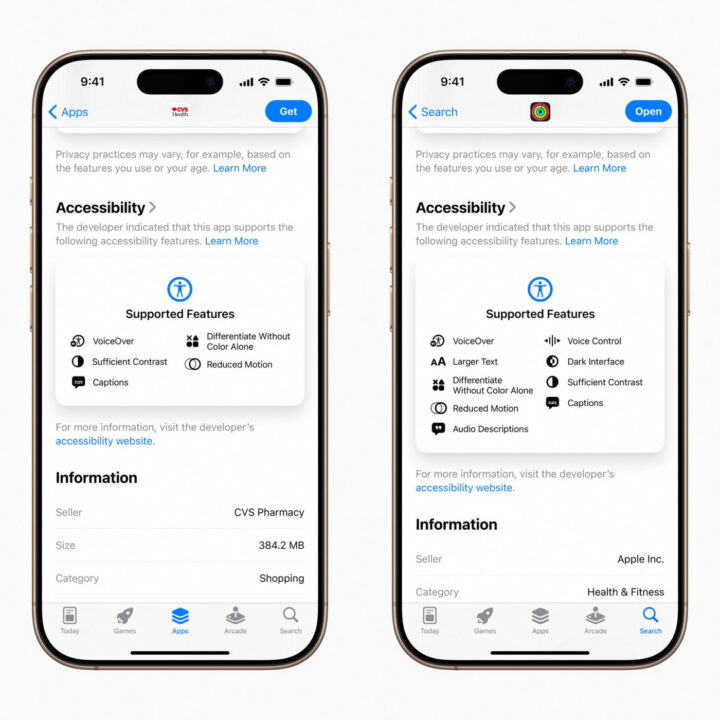

Une meilleure transparence sur l’App Store avec les étiquettes nutritionnelles de l’accessibilité

Parmi les nouveautés les plus marquantes, les étiquettes nutritionnelles de l’accessibilité feront leur apparition sur les pages produits de l’App Store. Ces étiquettes permettront aux utilisateurs de savoir, avant même le téléchargement, si une application répond à leurs besoins spécifiques. Les informations disponibles couvriront notamment la compatibilité avec VoiceOver, le contrôle vocal, les sous-titres, le texte en grand format, ou encore les contrastes suffisants.

Eric Bridges, président de l’American Foundation for the Blind, salue cette initiative : « Ces étiquettes représentent une avancée majeure. Les consommateurs doivent savoir dès le départ si un produit leur est accessible ».

Une application Loupe repensée pour Mac

Déjà présente sur iPhone et iPad, l’application Loupe arrive sur Mac. Grâce à la caméra de l’ordinateur — ou à une caméra externe connectée — les utilisateurs malvoyants pourront agrandir ce qui se trouve autour d’eux, comme un tableau blanc ou un écran. La fonction Desk View permet de lire des documents, et plusieurs fenêtres peuvent être affichées en simultané pour plus de flexibilité.

Il est aussi possible d’ajuster la luminosité, les contrastes ou encore les filtres de couleurs. Ces vues peuvent être enregistrées pour une utilisation ultérieure. Intégrée à cette nouvelle version de Loupe, la fonction du lecteur d’accessibilité permet de convertir du texte du monde réel en un format plus lisible.

Une prise de note complète en braille

Avec la fonction d’accès braille, Apple propose une véritable application de prise de notes en braille sur iPhone, iPad, Mac et Apple Vision Pro. Elle permet de :

- Lancer des applications à l’aide de la saisie braille

- Rédiger des notes et effectuer des calculs en utilisant le braille Nemeth, adapté aux disciplines scientifiques

- Ouvrir directement des fichiers BRF (Braille Ready Format)

- Profiter de transcriptions en direct via une intégration avec Live Captions

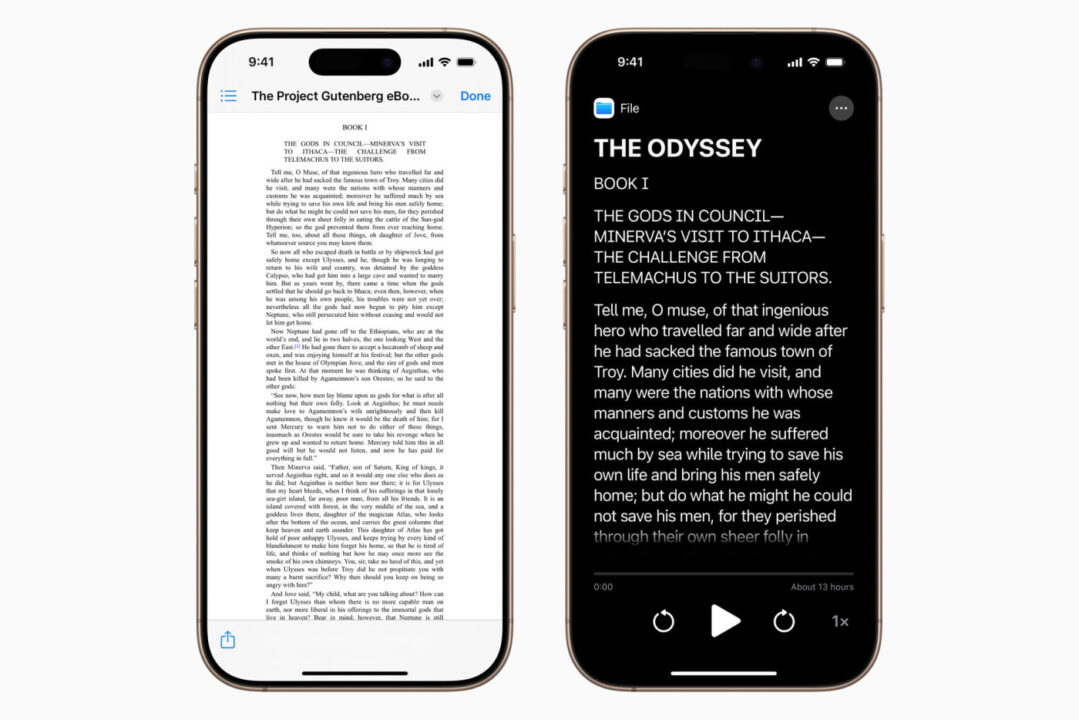

Lecteur d’accessibilité : une lecture adaptée à chacun

Disponible sur l’ensemble des appareils Apple, le lecteur d’accessibilité offre un mode de lecture universel, pensé pour les personnes atteintes de dyslexie ou de troubles visuels. Il permet une personnalisation fine des textes : choix de la police, de l’espacement, des couleurs, ou encore de l’activation de la lecture vocale. Cette fonction s’intègre également à l’application Loupe.

Les sous-titres en direct arrivent sur l’Apple Watch

Les utilisateurs sourds ou malentendants bénéficieront de la fonctionnalité d’écoute en temps réel sur Apple Watch. Celle-ci affiche en temps réel les sous-titres du son capté par l’iPhone, directement sur le poignet. Elle fonctionne avec les AirPods, les aides auditives certifiées Made for iPhone et les produits Beats. L’Apple Watch peut ainsi servir de télécommande pour démarrer ou stopper une session à distance.

Vision Pro et visionOS : zoom, reconnaissance et API pour développeurs

L’Apple Vision Pro intègre également de nouvelles capacités pour les personnes malvoyantes :

- Zoom sur l’environnement en temps réel

- Reconnaissance d’objets et de texte via l’apprentissage automatique

- Accès API pour permettre aux applications d’assistance visuelle d’utiliser la caméra principale du casque

Autres nouveautés notables

- Sons de fond : personnalisation avec égaliseur, arrêt automatique et intégration à l’app Raccourcis.

- Voix personnelle : création plus rapide d’une voix personnalisée en moins d’une minute. Support ajouté pour l’espagnol (Mexique).

- Mal en transports : la fonction déjà disponible sur iPhone et iPad débarque sur Mac.

- Suivi des yeux et suivi de la tête : interactions plus naturelles avec l’iPhone et l’iPad, sans les mains.

- Support des interfaces cerveau-ordinateur (BCI) : un protocole pour les personnes ayant de graves limitations motrices.

- Aide d’accès : nouvelle application Apple TV simplifiée pour les personnes ayant des troubles cognitifs.

- Retours haptiques musicaux : ressentir la musique par vibrations, avec un niveau de personnalisation accru.

- Reconnaissance sonore : identification vocale du prénom de l’utilisateur.

- Contrôle vocal en programmation : nouveau mode dans Xcode pour les développeurs à mobilité réduite.

- Sous-titres en direct : prise en charge élargie à de nombreuses langues, dont le français.

- CarPlay : support du texte large et reconnaissance de sons comme les pleurs de bébé ou les sirènes.

- Partage des réglages d’accessibilité : utile pour un appareil emprunté ou public.

Présentation des mises à jour à la WWDC 2025

Apple annoncera iOS 19, macOS 16, watchOS 12 et visionOS 3 lors de la keynote d’ouverture de la WWDC 2025 le 9 juin prochain. Il y aura la première bêta pour les développeurs dans la foulée.