FS-DFM : ce modèle IA d’Apple peut rédiger du texte 128 fois plus vite

Des chercheurs d’Apple, en collaboration avec l’université d’État de l’Ohio, présentent un nouveau modèle d’intelligence artificielle qui pourrait bien changer la donne. Baptisé FS-DFM, il est capable de rédiger des textes complets à une vitesse jusqu’à 128 fois supérieure à celle de ses homologues, tout en affichant une bonne qualité et une bonne efficacité, même face à des modèles beaucoup plus imposants.

Un système différent face aux modèles classiques

Pour comprendre cette avancée, il faut distinguer deux approches. Les modèles autorégressifs, comme ChatGPT, génèrent le texte de manière séquentielle, token par token. À l’opposé, les modèles à diffusion travaillent en parallèle mais nécessitent de nombreux cycles d’affinage pour converger vers un résultat cohérent. Le FS-DFM (Few-Step Discrete Flow-Matching) d’Apple se base sur une variante, le « flow-matching », et la perfectionne. Il réussit à produire un texte de haute qualité en seulement huit cycles, là où d’autres en requièrent plus d’un millier.

Le secret de cette performance réside dans une approche structurée en trois phases. D’abord, le modèle est entraîné pour s’adapter à différents budgets de cycles d’affinage. Ensuite, un « modèle professeur » intervient pour le guider, lui permettant d’opérer des corrections plus importantes et plus justes à chaque étape, sans pour autant dépasser le résultat visé. Enfin, le processus de chaque cycle est optimisé afin que le modèle atteigne sa cible en un minimum d’étapes stables et régulières.

Des performances qui surpassent des modèles bien plus grands

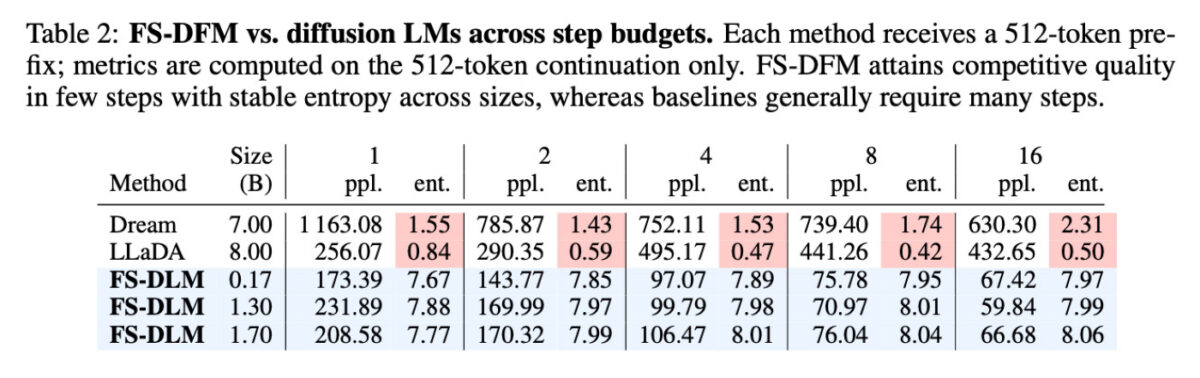

L’efficacité du FS-DFM d’Apple a été mesurée face à des modèles à diffusion concurrents, comme Dream (7 milliards de paramètres) et LLaDA (8 milliards de paramètres). Malgré leur taille bien plus modeste (de 170 millions à 1,7 milliard de paramètres), les variantes du FS-DFM ont systématiquement obtenu une meilleure perplexité, un indicateur clé de la qualité et du naturel du texte.

De plus, leur entropie, qui mesure la pertinence du choix des mots, s’est avérée plus stable. Pour encourager la recherche, les créateurs ont annoncé qu’ils prévoient de publier le code et les points de contrôle du modèle pour faciliter la reproductibilité et la recherche future.