[Keynote] Apple Intelligence : Apple met « son » IA à toutes les sauces (iOS, macOS, Mail, Siri, Genmoji, Image Wand, etc.)

C’était probablement l’annonce la plus attendue cette keynote, celle qui devait aussi prouver qu‘Apple n’avait pas loupé le train fou des LLMs et de l’IA générative, et c’est peu dire que la démonstration a été globalement très concluante. L’IA d’Apple s’appellera donc Apple Intelligence comme l’avaient prévues les fuites les plus récentes (et donc AI) et évidemment, la confidentialité et la protection des données de l’utilisateur est coeur du processus. Apple a mis en place un système baptisé Private Cloud Compute qui respecte la vie privée de l’utilisateur même lorsque l’IA s’appuie sur les serveurs de cloud. Et ces serveurs « confidentiels » tournent évidemment avec des puces Apple Silicon. Le système reste difficile à appréhender puisque l’ IA tournerait complètement en local (mais avec des serveurs de cloud donc…)., mais tout doit être forcément d’équerre puisque la firme de Cupertino affirme bravache que des experts pourront même vérifier que tout est « bordé ».

Priorité sur la confidentialité

Passons aux fonctions. Apple Intelligence est intégré au coeur même d’iOS 18, iPadOS 18 et Mac Séquoia, et comme on pouvait s’en douter, l’objectif d’Apple a été de rendre l’usage de l’IA le plus simples possible, les fonctions étant encapsulées dans des apps déjà connues de tous les utilisateurs de l’éco-système Apple. Apple Intelligence peut ainsi mettre en avant des notifications importantes reçues durant la journée (et mettre à l’écart les autres pour ne pas être trop dérangé). Il peut également vérifier le texte que l’on s’apprête à envoyer via mail ou Messages (voire le réécrire à la volée).

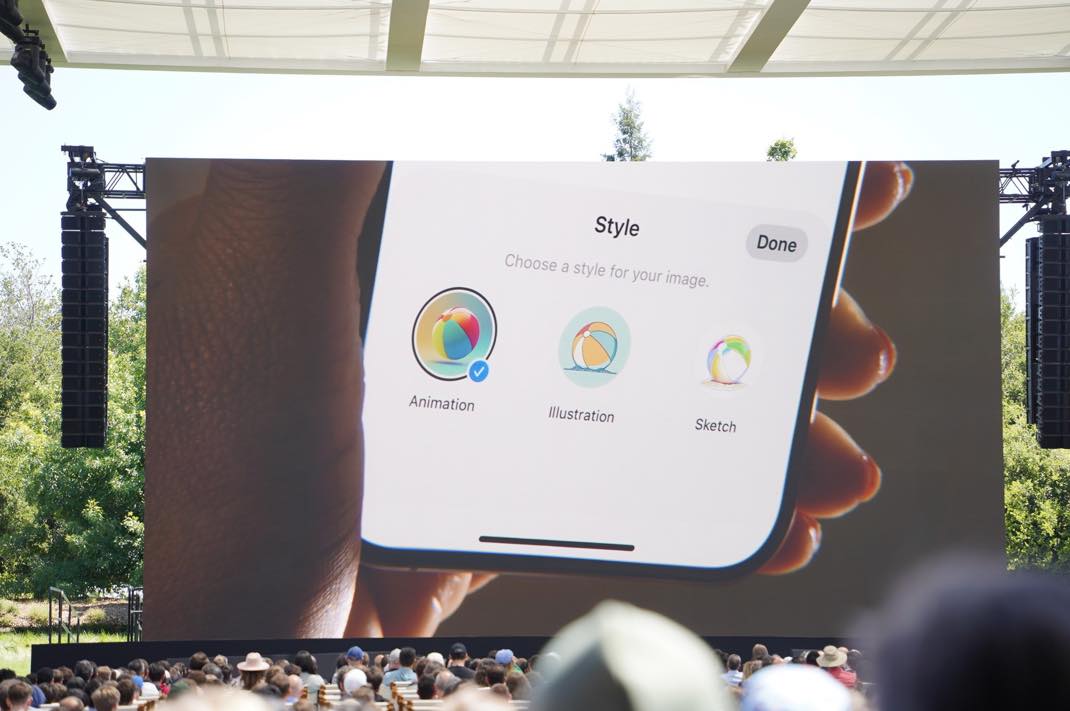

Apple Intelligence peut aussi agir sur l’ensemble des applications d’iOS, iPadOS et macOS. Il suffit de lui dire par exemple « consulter les fichiers » ou « lire le podcast », et il garde bien sûr le fil des requêtes formulées, donnant ainsi l’impression d’une « compréhension » plus globale. Le volume des améliorations donne littéralement le tournis : l’IA alimente un index sémantique sur l’appareil (iOS, iPAdOS et macOS) pour organiser et faire apparaître les informations provenant de différentes applications, peut générer des images à la volée notamment dans Messages (et reprendre la photo du contact pour la transformer en image selon les styles sketch, illustration et animation), sans oublier la plus grosse amélioration, : Siri.

La renaissance de Siri

L’assistant d’Apple rejoint enfin ses promesses initiales : Siri reconnait désormais aisément les phrases les plus complexes et répond à son tour avec des phrases complexes (malheureusement toujours avec un timbre très artificiel) et il est même possible de corriger vocalement une erreur de formulation à la volée sans que Siri ne perde le fil (et n’oublie pas d’intégrer la correction). Il est aussi désormais possible d’écrire à Siri (il suffit d’appuyer deux fois sur le bas de l’écran) et demander de décrire une tâche que l’on souhaite réaliser (l’assistant sert alors de guide).

Si l’utilisateur est dans une conversation et qu’il y a une adresse, l’utilisateur peut demander à Siri d’ajouter l’adresse à une fiche contact. Siri va automatiquement comprendre de quelle adresse il est question. Autre exemple, si l’utilisateur remplit un formulaire et qu’il est nécessaire d’entrer un numéro de permis de conduire par exemple, Siri peut automatiquement retrouver une photo du permis dans la photothèque, puis automatiquement extraire le numéro et le coller dans le formulaire. Pratique. Siri a aussi de la mémoire désormais : vous pouvez par exemple lui demander quand votre mère arrive à l’aéroport. L’IA aura remarqué cette information dans une conversation que vous avez eu avec votre mère dans le passé et va vous en faire part.

Mail surboosté par Apple Intelligence

Mail profitera à fond d’Apple Intelligence : l’IA peut générer un résumé des mails reçus, ou proposer des réponses contextualisées en fonction du contenu du mail. cerise sur le serveur, AI peut réécrire le mail en cours d’écriture selon des styles prédéfinis (professionnel, concis, décontracté). D’une façon générale Apple Assistance peut réécrire à tout moment, sur simple demande, une phrase ou un paragraphe pour en changer le style. Vous pouvez ainsi choisir un style et demander par exemple « écris le comme si c’était un poème ».

Et ça continue encore et encore…

Autre fonction, Genmoji, qui permet de générer des emojis, y compris à partir de l’image d’une personne. Image Playground est une nouvelle fonction qui guide l’utilisateur à travers un générateur d’images. Dans Notes, et sur iPad, Image Playground permet de transformer une esquisse en une meilleure image grâce à la fonction Image Wand. La partie média n’est pas oubliée : vous pouvez créer une vidéo à partir de vos clips en tapant simplement une description de ce que vous voulez, comme « Léo qui apprend à pêcher ». La recherche d’une photo ou d’une vidéo s’améliore. Il est aussi possible de faire une recherche « naturelle » et trouver facilement un contenu dans la bibliothèque Photo. Un nouvel outil dopé à l’IA permet également de supprimer facilement et rapidement des éléments gênants sur une photo.

Pour Finir, Apple prévient que toutes les fonctions d’Apple Assistance ne seront pas disponibles au lancement, et que les fonctions textuelles ainsi que Siri en mode avancé comprennent uniquement l’anglais. On n’est pas prêt de lâcher l’app ChatGPT…

Apple Intelligence nécessitera l’iPhone 15 Pro/Max et les iPad/Mac avec la puce M1 ou ultérieur.

Siri, tu m’avais manqué ! Je t’aime !

C’est plutôt une bonne stratégie d’intégrer 2 niveaux d’IA. ChatGPT pour le contenu et Apple Intelligence le plus intégré au système mais verrouillé par Apple.

Exactement !

Comprend uniquement l’anglais…

Pour le moment

« Apple Intelligence nécessitera l’iPhone 15 Pro/Max » c’est une honte !

Et vous pensez que c’est la Bêta qui ne sera disponible que sur l’iPhone 15 Pro ou aussi la version final ? Parce que sur leurs site il est indiqué que ça arrivera sur d’autre plateforme l’année prochaine

Dommage que tout les iPhones avant et en dessous le 15 Pro n’en profiteront pas !Copilot et ChatGPT, voir Gemini… sont donc à l’attaque pour 300 millions de devices.

Ainsi, si il faut un iPhone 15 Pro minimum pour profiter de cet IA… cela veut dire que plus de 300 Millions de devices auront encore la chance de télécharger et d’utiliser ChatGPT, Copilot ou Gemini….

Je comprend que cela demande pas mal de perf mais le rendre dispo que sur iPhone 15 pro c’est un peu raide je trouve

La deuxième partie de la conf était complètement dingue. Ça me faisait limite bizarre de voir autant d’innovation d’un coup de la part d’Apple. Ça faisait tellement longtemps qu’on attendait une conf aussi disruptive. Trop trop hâte de pouvoir essayer tout cela sur iPhone 😊

Ça n’aura été qu’un pet mouillé du coup, ce verrouillage a l’iPhone 15 Pro (pour relancer les ventes certainement et booster celle du 16) est un cruel dédain des utilisateurs. Il n’y a très probablement pas de limitation technique, certains se rappelleront l’épisode de Siri qui était dispo sur pratiquement tous les devices à l’aide du Jailbreak lors de sa sortie.