DarkDiff : Apple montre comment l’IA améliore les photos dans l’obscurité

Des chercheurs d’Apple et de l’université Purdue aux États-Unis ont développé le modèle DarkDiff pour restaurer les détails des photos prises en conditions de très faible luminosité. Cette intelligence artificielle intègre un modèle de diffusion directement dans le flux de traitement de l’image pour contrer le bruit numérique sans lisser excessivement le rendu.

DarkDiff réorganise le traitement du signal d’image d’Apple

Les algorithmes actuels de traitement d’image tentent de compenser le manque de lumière capté par le capteur, mais ils sont souvent critiqués pour leurs résultats artificiels. Ces méthodes créent fréquemment un effet de « peinture à l’huile » où les détails fins disparaissent ou deviennent illisibles. Pour corriger cela, les chercheurs ont choisi de ne pas appliquer l’IA uniquement en post-traitement.

Au lieu de cela, l’équipe a réaffecté Stable Diffusion, un modèle open source entraîné sur des millions d’images, pour l’intégrer au cœur du traitement du signal d’image (ISP). La puce du capteur photo continue de gérer les premières étapes cruciales, telles que la balance des blancs et le dématriçage pour interpréter les données brutes du capteur. DarkDiff intervient ensuite sur l’image RGB linéaire pour la débruiter et générer directement l’image sRGB finale.

« Nous introduisons un nouveau cadre pour améliorer les images brutes en basse lumière en réaffectant des modèles de diffusion génératifs pré-entraînés avec l’ISP de la caméra », précisent les chercheurs dans leur étude.

Le modèle optimise la netteté et limite les hallucinations

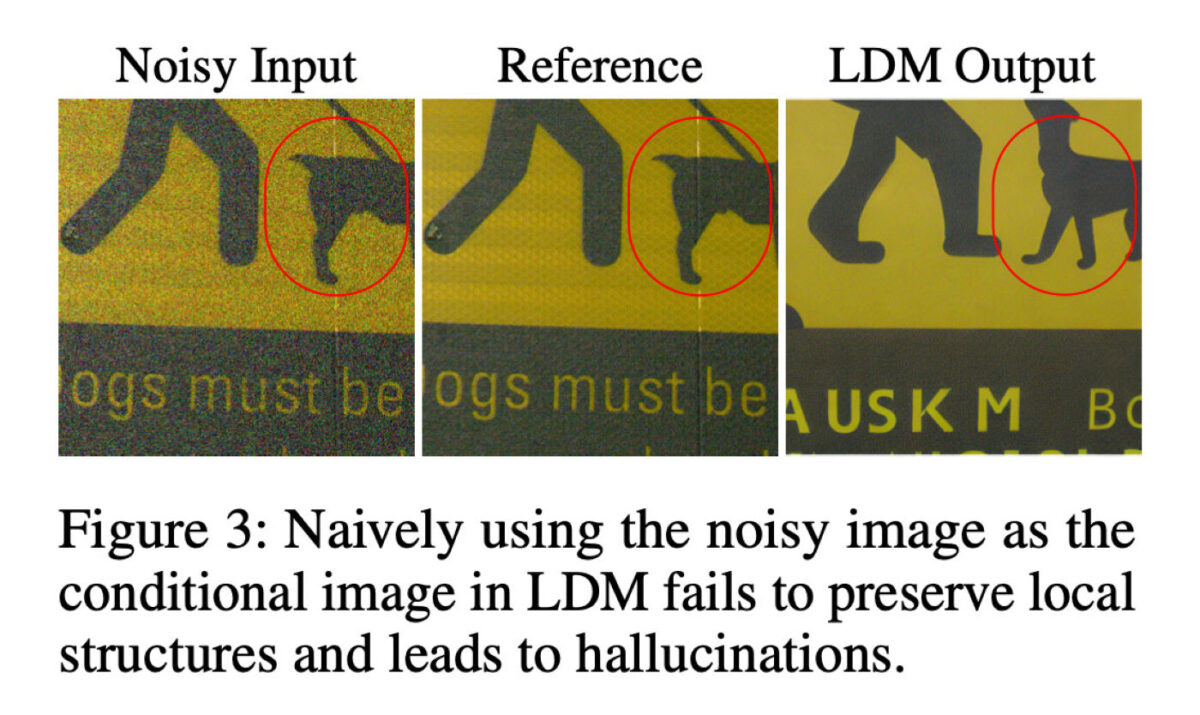

L’approche technique de DarkDiff repose sur un mécanisme qui calcule l’attention sur des zones d’image localisées. Cette méthode aide à préserver les structures locales et réduit le risque d’hallucinations visuelles, un défaut courant où l’IA modifie entièrement le contenu de l’image.

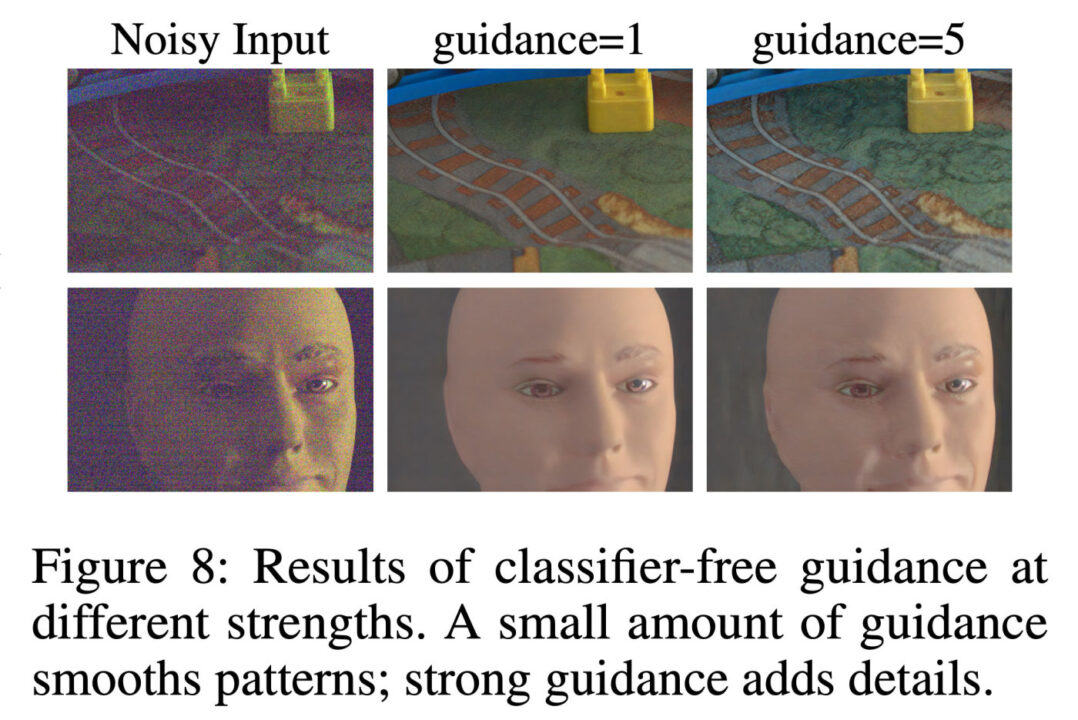

Le système utilise également une technique standard de diffusion appelée « guidage sans classificateur ». Ce paramètre contrôle l’équilibre entre le respect de l’image d’entrée et les connaissances visuelles apprises par le modèle. On retrouve un guidage faible qui génère des motifs plus lisses, ainsi qu’un guidage élevé qui favorise des textures plus nettes et des détails fins, augmentant toutefois le risque d’artefacts.

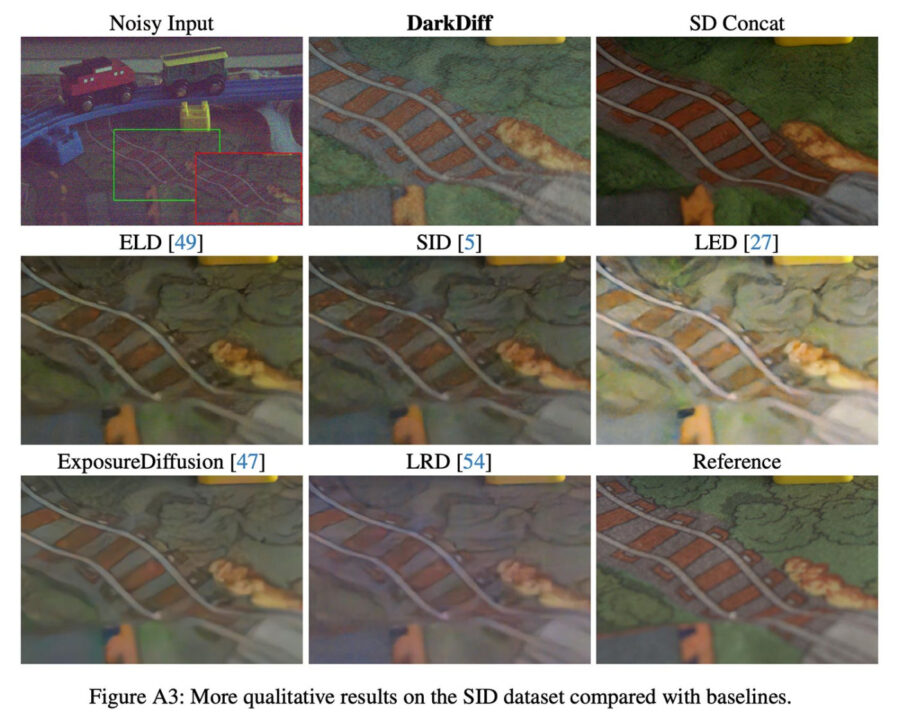

Selon les expériences menées, cette méthode surpasse l’état de l’art en matière de qualité perceptuelle sur trois bancs d’essai d’images brutes en basse lumière.

Des contraintes existent pour l’instant

Pour valider leur modèle, les chercheurs ont utilisé des photos réelles prises avec des appareils comme le Sony A7SII dans des conditions d’obscurité extrême. Les images de test, capturées avec un temps d’exposition de seulement 0,033 seconde, ont été comparées à des clichés de référence pris sur trépied avec une exposition 300 fois plus longue. DarkDiff a également été confronté à d’autres modèles de base, dont ExposureDiffusion.

Malgré ces avancées, la technologie présente des limites notables. Le traitement par IA est significativement plus lent que les méthodes traditionnelles. Les exigences de calcul élevées auraient un impact important sur l’autonomie si elles étaient exécutées localement sur un téléphone, ce qui suggère qu’un traitement dans le cloud serait nécessaire.

Par ailleurs, le modèle éprouve des difficultés avec la reconnaissance de textes qui ne sont pas en anglais dans les scènes sombres. L’étude ne mentionne pas d’arrivée prochaine sur les iPhone, mais elle illustre l’intérêt croissant du marché pour la photographie s’appuyant sur l’IA capable de dépasser les limites physiques des appareils.