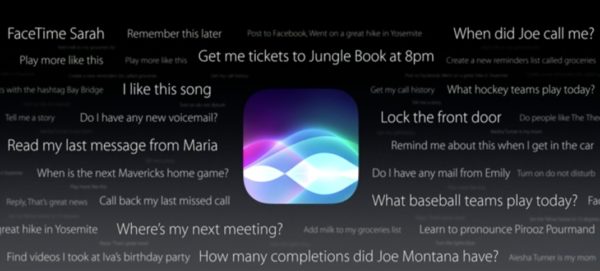

[Analyse] Pourquoi Siri semble ne rien savoir de l’utilisateur, à contrario de Google Assistant ou Alexa

Lors de cette WWDC 2017, Apple a beaucoup parlé des qualités sonores de son HomePod, beaucoup moins aussi de ses capacités d’assistant intelligent. Comme si Siri n’était plus l’un des atouts maitres de l’enceinte connectée, relégué (loin) derrière les capacités sonores et surtout musicales de l’engin; il fut pourtant un temps, pas si lointain, où Apple vantait les capacités de son assistants vocal, mais ça, c’était avant l’arrivée sur le marché d’Alexa et de Google Assistant, deux solutions qui s’avérèrent très vite nettement plus complètes et riches que Siri, notamment au niveau des services attenants, mais pas seulement : Google Assistant semble en effet tout connaitre de l’utilisateur, et pour cause puisque le logiciel de Google est adossé aux immenses ressources Big Datas du numéro un de la recherche.

Amazon et Google ne se cachent pas en effet d’exploiter et de croiser au maximum les données de leurs utilisateurs, données dans lesquelles les IA peuvent piocher pour contextualiser leurs réponses et surtout devenir pro-actives, c’est à dire anticiper les requêtes des utilisateurs en fonction de certains contextes (heure de la journée, géolocalisation par exemple) et des informations accumulées sur l’utilisateur (informations Gmail, fréquence de telle ou telle question, habitudes de vie cernées avec les trackeurs d’activités, etc…).

Du côté de Siri, il n’y a rien de tout cela, du fait même de la politique de confidentialité suivie par Apple. Comme l’explique fort bien Tim Bajarin dans un article limpide, Apple ne rattache pas l’Apple ID (identifiant utilisateur rattaché à une liste d’informations comme l’adresse, le code bancaire, etc.) à la requête de l’utilisateur de manière à accroitre la pertinence de la réponse fournie. A chaque question posée à Siri, des algorithmes se mettent en branle au coeur d’iOS et créent un identifiant numérique aléatoire (de type 05764373938) qui sert avant tout à améliorer la reconnaissance vocale; au bout de 6 mois, un nouvel identifiant numérique est généré, l’ancien (et les fichiers vocaux attenants) étant encore gardé 18 mois dans les serveurs d’Apple afin d’améliorer globalement le système. En d’autres termes, lorsque je pose une question à Siri, ce dernier ne peut pas récupérer mon identifiant pour contextualiser des réponses plus appropriées et faire du pro-actif réel. Les seuls éléments de contextualisation sont liés à iTunes ou à l’iBooks Store, parce que ces services savent ce que j’écoute ou ce que je regarde; mais…c’est tout.

Bien au chaud dans des sociétés modernes et respectueuses (pas toujours) des droits des citoyens, on ne voit pas forcément tout de suite l’intérêt d’un tel choix technologique de la part d’Apple; mais tous les utilisateurs de smartphones ne vivent pas dans des pays respectueux de la confidentialité des données privées, et certains pays n’hésitent pas à demander aux GAFA une masse importante d’informations sur certains utilisateurs lorsque ces derniers sont « dans le viseur », et pas toujours pour des raisons de sécurité nationale (cela peut-être aussi des activistes, de simples opposants politiques, etc.). Le fait est que du côté d’Apple, les mandats et autres demandes judiciaires (ou policières) ne peuvent au mieux qu’obtenir des informations sur ce qui est stocké dans l’iCloud de l’utilisateur (ce ne sera bientôt plus possible étant donné qu’Apple travaille à chiffrer entièrement son nuage); si l’iPhone/iPad est verrouillé, alors le système se transforme en une véritable boîte noire.

En revanche, du côté d’Amazon ou de Google, ces limites n’existent pas, et quantités d’informations de l’utilisateur sont stockées dans les serveurs Big Datas de ces entreprises, ce qui améliore grandement la pertinence de Google Assistant ou d’Alexa… mais ne protège plus l’utilisateur contre des régimes qui sont parfois tout sauf démocratiques (d’autant plus que nombre de pays sous régimes autoritaires ou dictatoriaux forcent désormais les grosses sociétés US à localiser les fermes de serveurs qui traitent les informations de leurs ressortissants).

Par simple cynisme, il serait facile de mettre en doute les motivations réelles d’Apple concernant ces choix de confidentialité, mais les chiffres de ventes du côté d’Android ainsi que les motivations réelles des iPhone-users démontrent pourtant que le californien n’a absolument rien à y gagner en terme économique, ou si peu. C’est d’autant plus vrai que les IA mobiles ne cessent de progresser et pourraient bientôt devenir un vrai argument de vente (ce qu’elles ne sont pas encore), ce qui explique sans doute qu’Apple tente désespérément de trouver des solutions équivalente à celles de Google ou Amazon tout en garantissant la continuité de sa politique de protection des données de l’utilisateur. On sait qu’Apple travaille sur une ferme de serveurs dédiée au Machine-Learning (mais toujours pas de Big Datas) et tente de mettre au point un processeur Neural Engine qui pourrait « déplacer » certains traitements d’IA au coeur même de l’iPhone…ce qui permettrait de contextualiser et recouper des informations utilisateurs à l’abri du chiffrement d’iOS.

La reprise en main du GPU de l’iPhone pourrait participer de cette offensive : plus de puissance de traitement, beaucoup plus, pour fournir une IA qui ne soit plus totalement dépendante de serveurs de calculs externes. Cette stratégie a ses limites propres : il n’est toujours pas possible dans cette configuration de se servir des usages cumulés des millions d’utilisateurs iOS afin améliorer la pertinence globale de l’IA (hors reconnaissance vocale), qui, au mieux, pourrait seulement se baser sur l’ensemble des données d’un utilisateur unique. A voir donc si ces choix seront suffisants pour contrer la progression – sans contraintes techniques – de concurrents qui ont déjà une bonne longueur d’avance…

👍🏻

Article très intéressant, merci

Her

Sympa la référence à l’OS de Her 👍

C’est de l’enfumage.

en fait Apple bride tout et nous frustre pauvre idiots accro aux marques de luxe que nous sommes 😂

Belle analyse merci Fred. Et vive Siri !

Alors a quoi sert de mettre un assistant si c est pour le brider ?

Personnellement j accroche pas mais si il est proposé il doit être entier.Libre a toi de l activer ou pas

Vous réfléchissez un peu ? Ce n’est pas du bridage c’est de la protection. Et si on introduit une activation on ouvre une porte au contournement. C’est comme le verrouillage et le chiffrage.

Pourtant ils y arrivent bien sûr Android…

Oui ils y arrivent bien

Mais Android c’est Google.

Le plus gros publicitaire sur internet.

Ils vendent les donnes des utilisateurs.

C’est simple, Google propose des services pour mieux vous connaître.

Apple propose des services pour mieux vous satisfaire

Faute! Google propose des services pour se faire plus de thune et sur le dos de l’utilisateur s’il vous plaît!