Apple annonce scanner les photos des utilisateurs pour lutter contre la pédopornographie

- Jean-Baptiste A.

- 5 Août 2021à 22:19

- Apple, z

- 15 partages

- 50

- 4

Apple a présenté de nouvelles initiatives dans la lutte contre la pédopornographie, dont un système d’analyse des photos des utilisateurs. Cela concerne les photos qui sont sur iCloud et cela implique aussi l’iPhone. Cela confirme une information qui a été publiée ce matin.

Analyse des photos par Apple en rapport avec la pédopornographie

Avec iOS 15, Apple sera en mesure de détecter les images connues pour les abus sexuels d’enfants en faisant une comparaison avec celles des utilisateurs qui sont sur iCloud. Apple se chargera de signaler les utilisateurs qui ont de tels contenus auprès des organismes qui collaborent avec les forces de l’ordre.

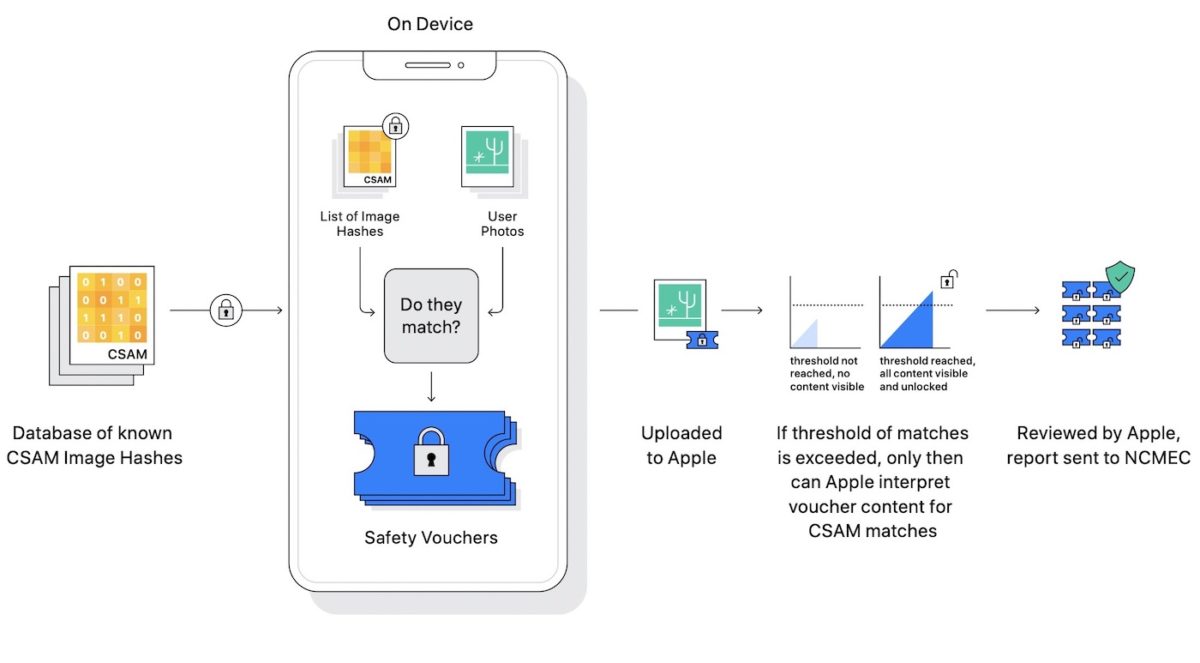

Naturellement, certains peuvent estimer qu’il s’agit d’une violation de la vie privée. Mais Apple assure que son mécanisme est pensé avec la confidentialité. L’analyse des photos se fait directement sur l’iPhone, au lieu d’avoir lieu sur des serveurs. Une comparaison a lieu avec une base de données pour voir une image est la même qu’une autre en rapport avec la pédopornographie. Cela fonctionne également si l’image est en noir et blanc ou a été recadrée. Apple précise qu’il transformera ensuite cette base de données en un ensemble illisible de hachages stockés en toute sécurité sur les appareils des utilisateurs. La technologie de hachage, qui a pour nom NeuralHash, analyse une image et la convertit en un numéro unique spécifique à cette image.

Comment se déroule le processus ? Apple reçoit d’abord une alerte en cas d’images qui semble avoir un rapport avec la pédopornographie. Un employé du fabricant fait alors une vérification pour voir si l’alerte est légitime. Si c’est confirmé, alors l’employé désactive le compte iCloud de l’utilisateur et envoie un signalement aux autorités. Apple assure au passage que son système est « très précis ».

Cette nouveauté concernera d’abord les États-Unis au départ. Mais Apple prévient que le système va débarquer dans d’autres pays au fil du temps.

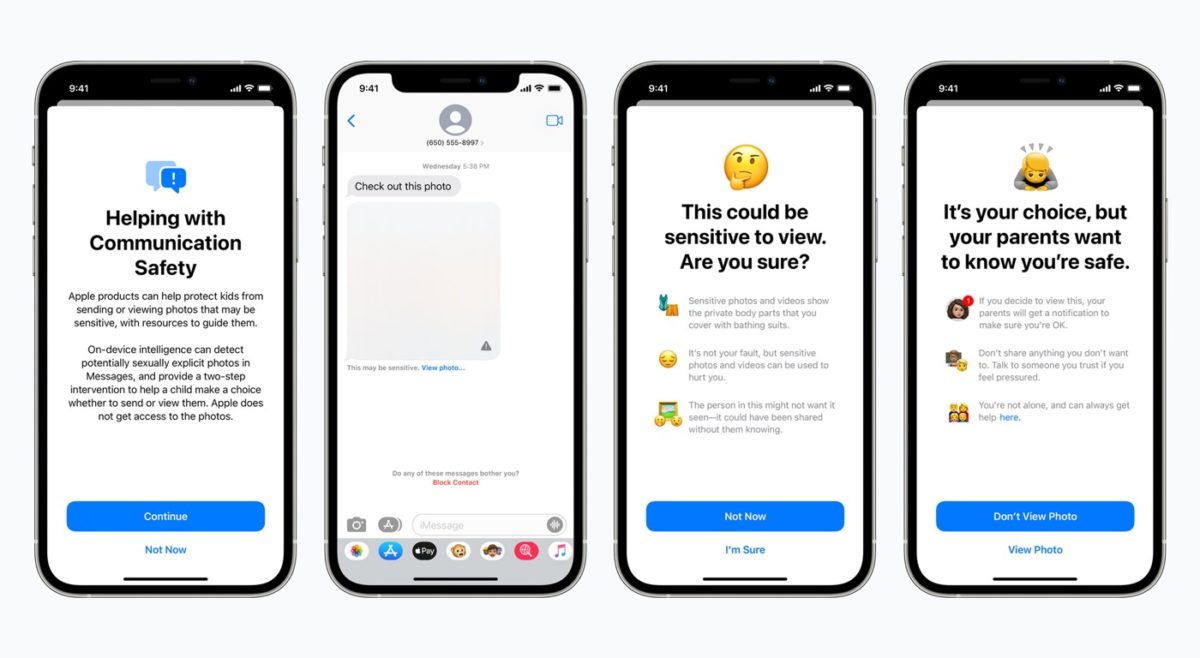

Des alertes sur iMessage

Une autre initiative d’Apple pour lutter contre la pédopornographie concerne iMessage. L’application Messages va afficher un pop-up pour mettre en garde les enfants et leurs parents lors de la réception ou de l’envoi de photos sexuellement explicites. Du machine learning directement sur l’iPhone est utilisé pour analyser les images. Si une photo se veut sexuelle, l’application Message la floute et l’enfant reçoit un avertissement. Apple ne souhaite pas qu’il l’ouvre. Du côté des parents, il est possible de recevoir une notification lorsque l’enfant ouvre la photo malgré l’avertissement ou envoie une photo sexuelle à un autre contact.

Ce sera en place avec iOS 15 et macOS Monterey. Apple assure que les conversations iMessage sont toujours chiffrées, même avec ce système de détection d’images sexuelles.

Siri proposera des ressources

Enfin, Apple va améliorer Siri en proposant davantage de ressources pour aider les enfants et parents à rester en sécurité et recevoir de l’aide si c’est nécessaire. Par exemple, Siri pourra aider les personnes qui veulent signaler de la pédopornographie. Les organismes qui s’en chargent seront affichés dans une liste.

Ce sera en place avec iOS 15, macOS Monterey et watchOS 8.

Sky : Copier

Louis : Collee

Très dangereux de pouvoir vérifier les photos du Cloud des utilisateurs….

Et ils parlent de confidentialité ? Et on utilise comment un iphone sans devoir se connecter avec identifiant Apple afin de ne pas être dans le Cloud ? Possible ou pas ?

Je reste sans voix

Sa yai on retourne comme en 40 et le tmp des dictateurs

mais non, Les Usa sont la mailleure des démocratie. Ont assez critiqué la Chine…Là on parle de choses graves avec des enfants, mais les sites comme youporne, redTub et autres vont être bloqués par leur vpn maison peut-être ?

Un (e) enfant de 14 à 16 ans ne peut pas être comparé à un adulte dans une vidéo…

c’est beau ce qui arrive….vive la liberté.

La meilleure des démocraties bahahaha

Justement…ironique…on s’attaque à la sexualité (ici c’est pour protéger les enfants) mais d’un autre côté, la vente d’armes est tolérée, les jeux violents sont tolérés, les séries comme SEE sont mises en avant avec coupage de tête, torture et sexualité dépravée sans sanction, Apple jouent à je ne sais pas quelle jeu là….

Les usa sont des faux cul ils ont construit leur payer en volant les européens c bien de lutter contre la pedo mais au point de ce balader avec un membre du fbi dans la poche autant dire que nous tous allor en liberté conditionnel

Autant je défends souvent Apple sur la sécurité et la confidentialité mais la ca va trop loin , la cause est importante mais laissez ce travail à qui ça concerne la vous avez clairement accès à toutes les photos des utilisateurs , et si j’ai une photo de moi ou ma copine sur mon téléphone et que l’intelligence artificielle fonctionne mal ma photo se retrouve devant l’écran d’un employé Apple ?? C’est honteux !

Mais qu’est-ce que tu as besoin de foutre des photos de ta copine dans son bain sur le cloud ???

Très bonne initiative de la part d’Apple

Quand tu prendras conscience de toute les dérives que cela peut engendrer il sera trop tard 👌🏻

Toutes les dérives ? Tu veux parler des gamines qui ce sont suicidé à cause des photos dénudé que leurs camarades de classes font tourner ? Des mecs qui abusent, prennent en photo des jeunes filles dans les transports en commun ou encore pire viole les enfants ? Les dérives elles sont là et personne fait rien.

Donc tu cautionnes le fait qu’Apple fouille dans tes photos et dans ta vie privée. C’est bien les mecs continuaient à applaudir ça. Faudras pas venir pigner quand on ressemblera à la Chine 😉

lisez plus haut, un enfant de 14 ans ne peut être différencier par photo à un adulte. Vous avez sûrement déjà mâté des photo de mannequins filles qui avaient juste 15 ans…

Je suis très mitigé sur ce genre de chose, Apple peut donc avoir accès à toutes nos photos c’est grave je trouve

Relis l’article, ce n’est pas ce qui est marqué

Si, il y a alerte pour Nu chez Apple et un employé contrôle….ensuite le compte est désactivé.

Par contre un truc qui me semble un peu flou. Par enfant ils considèrent jusqu’à quel âge ?

Comment ils déterminent l’âge de l’enfant ? Avec qu’elle donnée ?

Je trouve ça très très limite… on commence avec les enfants et demain ça sera quoi ? Ce genre de pratique est dangereuse

Ce que je comprends en lisant le début de l’article c’est juste qu’il y a une base de données de photos à caractère pedophile et Apple va juste faire comparer ces photos aux photos des utilisateurs dans le cloud et l’iPhone. Il n’est aucunement question selon moi de scruter les photos des utilisateurs pour déterminer à chaque photo si elle est ou pas illicite, mais de voir si parmi les photos un utilisateur en possède une ou plus qui circule et est connue pour être illégale.

Bon ba il va falloir finir chez … chez qui du coup ? BlackBerry ?

Parce que là ça commence par le flicage de photos puis quoi après ?

Faut prendre le temps de lire et regarder l’image !

Il s’agit de comparaison des photos des utilisateurs avec une base de données de photos connues pour être pedopornographiques. La base de comparaison est stockée sur l’iPhone et la comparaison se fait sur l’iPhone et s’il y a une correspondance il y a alerte chez Apple….

Un employé d’apple fait une vérification 😳

Mais de quel droit ?

Quels sont les critères d’une image pedo pornographique ?

Et comment être sûr que les photos ne seront pas recherchées sur d’autres critères ?

Du coup Apple c’est fini la confidentialité 🤬

C’est l’iPhone lui même qui scanne les photos. Donc aucune intrusions tant que y’a pas de gosse de 2 ans a poile entrain de faire je ne sais quoi sur ton tel. Je vois pas le problème perso.

Oué donc en gros, la photo que tu prends de ton enfant quand il est tout bébé dans son bain, ce sera considéré comme de la pédopornographie infantile ???? Tout le monde le fait je pense….

Ca va vite partir en vrille ce système je pense….

Je ne dis pas qu’il ne faut pas lutter contre la pédophilie, mais encore une fois, c’est Apple qui décidera des photos que tu peux faire ou non….

On va se retrouver avec les flics devant notre porte selon le bon vouloir des vérificateurs Apple. Si c’est comme avec les applications qui sont validées ou refusées au bon vouloir d’Apple, ça s’annonce beau…

J’ai pensé à la même chose que vous ! Et en réfléchissant, j’ai trouvé cela. Sur votre iPhone, vous pouvez configurer des visages, qui après, une fois que le programme de l’iPhone les a assimilés, pourra reconnaître une personne sur chaque photo où se trouve la personne (même si l’on ne voit pas totalement son visage). J’ai alors pensé que cette fonctionnalité pourrait éventuellement empêché la police de venir à votre porte. Même si ça reste encore bien trop peu rassurant

Heureux d’apprendre qu’Apple à la possibilité d’analyser mes photos personnelles sur iCloud.. la peinture s’effrite !

Donc du coup on va nous supprimer du stockage contre notre gré et ouvrir une porte à un flicage massif… La fin peut être louable mais le moyen lui est de très mauvais augure…

Vous avez pas encore compris le nouveau monde qui arrive.. bon vaccin 😂

Hors sujet pour polémiquer délibérément, reste loin de nous avec ton corps toxique et comportement toxique

T’es agressif c’est un effet secondaire ?? 😂😂

Il s’agit juste d’une comparaison en local sur l’iPhone des photos de l’utilisateur avec une base de données de photos pedopornographiques reconnues en tant que tel. Faut arrêter de tirer des conclusions et comprendre ce qui est écrit.

« Un employé du fabricant fait alors une vérification pour voir si l’alerte est légitime. »

Apple a donc accès à tes photos iCloud, contrairement à tout ce qu’ils peuvent dire sur leur site :

« iCloud protège vos informations en les chiffrant lorsqu’elles sont transmises, en les stockant dans iCloud dans un format chiffré et en utilisant des filtres sécurisés pour l’authentification. Personne, pas même Apple, ne peut accéder aux informations chiffrées de bout en bout. »

Voilà :)

Quelle naïveté 🙄

Ne pas avoir votre point de vue ne fait pas des autres des personnes naïves ! Déjà je n’ai pas donné mon point de vue sur le sujet je ne fais que dire différemment ce qui est expliqué, car quand je vois certains qui commentent et qui n’ont rien compris au procédé qui est expliqué ! Autant critiquer sur ce qui est et non sur ce qu’on croit que ce sera !!!

Quid des photos de nains dénudés ? Quid des enfants ( je prend mon exemple ) qui joue parfois cul nu dans la piscine et qu’ont prend une photo pour des souvenirs ? Du coup même à la plage si elle est juste les gougoutes a l’air et je prend une photo ? Si c’est comme facebook ou une simple photo d’un genoux te dit bloqué car considéré comme de la pornographie … ça promet. Et maintenant une preuve de plus qu’Apple vous surveille et s’amuse avec vos données et se fait du fric aussi avec. Ça va être dur de défendre la confidentialité maintenant chez Apple …

T’as rien compris ! Personne va dire si la photo que t’as pris de ton gamin est à caractère pedophile ou pas ! Il s’agit de savoir si dans tes photos tu n’as pas des photos qui sont connues pour être de caractère pedophile! Et ceci en comparant tes photos à une base de données !

Le droit au secret et à l’anonymat sur internet est une connerie. Je ne sais pas comment il faut vous le dire.

Tu ne fera pas d un âne un cheval de course même en lui coupant les oreilles

Mais comment apple arrive a avoir une bases d images pedopirnographiques ? Je pensais que seuls les forces de l ordre était détenteur de ce genre de base. La façon d opérer est contradictoire avec les lubertes fondamentales ,

Surveiller encore plus en utilisant le prétexte de la lutte contre la pedocriminalité. Qui va croire cela a part 2-3 idiots du village

Ca y est me voila complotiste

Chacun son taf, Apple concentre toi sur le tiens…

Confidentialité quand la photo est vu par un employe ? 😂

Cette fonctionnalité va pousser les utilisateurs septiques ou réfractaires a ne plus ou pas utiliser icloud et de ce fait , acheter un nouveau modèle d’iphone avec plus de capacité de stockage.

Cette nouveauté est mise en place peu de temps avant la sortie du nouvel iphone, c’est bien joué 👍.

Je ne crois pas. Il semble que les photos sont déjà scannees sur l’iPhone. Du coup les sceptiques auraient plutôt intérêt à changer de marque (et si possible pas un téléphone sous Android qui risque fort d’être bien pire)

Tout à fait d’accord avec toi 🤔

Hummm 🤔ça sent mauvais tous ça 🤔

Essayez juste d’être moins bête, ce sont des hash que Apple compare te non pas vraiment la photo. A chaque hash positif un ticket est émis, au bout d’un certain nombre de ticket alors les photos sont comparées visuellement par un humain. Cela me semble à la fois protéger la vie privée et combattre la pédophilie.