Pédopornographie : le système de hachage d’Apple déjà hacké et sensible aux faux-positifs ?

Voilà qui ne va pas arranger les affaires d’Apple. Le développeur Asuhariet Yvgar affirme être parvenu – par rétro-ingénierie – à récupérer le code de l’algorithme de hachage utilisé par Apple sous iOS 15 afin de vérifier que les photos de l’utilisateur ne contiennent pas de contenus pédopornographiques. L’algorithme NeuralHash, qui était bien planqué dans les tréfonds d’iOS 14.3, a été ensuite recompilé en python et soumis à des tests d’intégrité par d’autres utilisateurs. L’un de ces vérificateurs est parvenu à créer un faux positif, c’est à dire une correspondance du code de hachage pour deux images totalement différentes, une anomalie pourtant « impossible » selon les dires d’Apple.

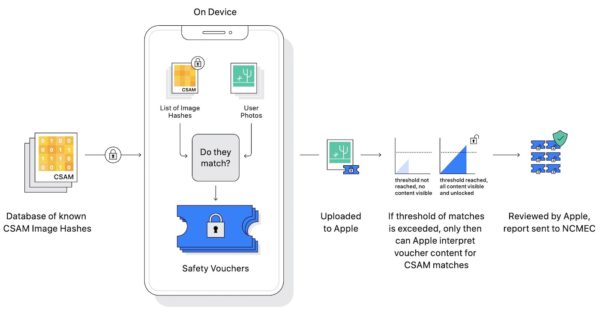

Face au bad buzz inévitable qui risque de suivre cette malheureuse découverte, Apple a prestement réagi auprès du site Motherboard, expliquant que la version de l’algorithme NeuralHash récupérée par Yvgar n’était pas identique à celle qui serait finalement implémentée dans iOS 15. Apple rappelle que son système de hachage a été soumis à évaluation à des experts en sécurité informatique, qu’un serveur contrôlera une seconde fois chaque correspondance de hachage et qu’in fine des employés en chair et en os effectueront la vérif finale.

L’explication d’Apple n’a pas vraiment convaincu Matthew Green, enseignant en Cryptographie à la Johns Hopkins University, qui estime que si le premier code a permis de générer des faux-positifs, il en sera de même pour l’algorithme final implémenté dans iOS 15. Un autre chercheur, Nicholas Weaver, estime cependant que le contrôle humain en bout de chaîne devrait annuler les risques de faux positifs, d’autant qu’une trentaine d’images doivent correspondre pour que le système alerte les autorités.

Un point n’est malheureusement pas abordé : qu’en sera t-il en si une entité (une dictature par exemple) décide de se débarrasser d’un individu (un opposant politique par exemple) en piratant son iPhone et en balançant dessus des images compromettantes ? Cette technique de « création du coupable » a déjà été utilisée par le passé, et elle sera à priori largement facilité par le système d’Apple puisque les autorités seront directement alertées avant même que l’individu cible puisse prendre connaissance du piratage.

Pas plus mal, iOS sera d’autant plus allégé, car comme tourne cette nouvelle fonction déguisée, Apple devront annuler.

Même si la pomme vérifie ou fait faire re-vérifié leur systèmes de contrôles dont le fond n’est pas mauvais en sois pour la lutte contre c’est (C…ard de vicieux), par une horde d’ingénieur en tout bore, ils et reconnu qu’ils existe aucun logiciels qui et a l’abri d’un bug, faille de sécurité, ou autres et pour l’IOS pas la peine de parlé du jailbreaks qui suis le systèmes IOS depuis des années, dont l’IOS 15 n’échappera pas la règle, Apple devrait resté une entreprise qui fait rêvé les amoureux de technologies, geek, etc.. et non devenir une entité de contrôle du comportement, ou flicages des utilisateurs, pour la bonne cause, pour cela ils y a d’autre entité, spécialisés dans le domaine, ainsi que la justice pour ce boulot… et non le faire à leurs place.

à moins bien-sure qu’ils ont un contrat avec la nsa… ;)

Malheureux ! J’ai dénoncé NSA dans la première News là dessus et on m’a incendié il y a 10 jours….

Quelque chose qui dérange, ou parle pas de la même voix font toujours réagir les invétérés & Amoureux de la marque, ils faut que sa passe dans le journal de 20H pour que sa soie crédible, ni prête pas attention et continu a donné t’es avis,

tout le monde n’a pas les mêmes chaussures aux pieds ;)

Il faut déjà que l’info du 20h soit libre…Rien sur les 3500 morts aux USA du covid en 3 jours…on admire leur vaccination et le reste censuré…

Malheureusement, ils ont décidé d’implanter ce système, et faire des découvertes comme ça ou des pétitions pour retirer la fonction ne changera rien et tout le monde le sait. Ils ont décider de mettre ça et ils le mettront.

Arrêtez d’acheter des iPhones si vous n’êtes pas content de cette fonctionnalité. Perso c’est ce que je vais faire, hors de question de participer à cette mascarade

Mdr tu vas faire quoi ? Aller sur Android, c’est bourré de backdoors tous les services secrets ont un accès sans soucis…

Apple n’aurait pas du communiquer publiquement sur le nombre d’image nécessaire a la détection de ces images.

Autrement dit, si les pédo stock et se partage 20 images par 20 images, ils ne seront jamais détecter.

Soit ce nombre de 30 est une fake news pour justement faire baisser la garde a ce genre de mer’e et les chopper dés qu’il sotck 1 image, soit c’est une erreur de communication.

Tout à fait même 29 a priori

Si ce point n’est pas abordé c’est peut-être parce que la question est stupide. Il n’y a pas besoin d’iPhone pour créer des coupables et la manœuvre n’est pas plus discrète ni plus efficace avec des photo pédo-porno qu’avec autre chose. L’argument « mais si ça tombe entre de mauvaises mains » ne pèse rien

Tout à fait ! Pas mal de choses peuvent être détournées de leur utilisation, pour laquelle elles ont été inventées à la base, et servir à d’autres fins… Faut il mettre l’outils aux oubliettes ou surveiller/contrôler qui l’utilise ? Ne devrait on pas supprimer les voitures avec tous ces morts sur la route ? 🤣

Pour le coup on pourrait supprimer tout objet qui prend des photos ?

Vous avez vraiment lu (et compris) ce qui est écrit dans l’article ? Votre réponse semble indiquer que non. L’automatisation d’Apple pourrait largement faciliter la création de faux coupables. L’article dit bien que justement cela a toujours existé, mais que la méthodologie employée par Apple va encore FACILITER ce type de coup bas. Faciliter.

Aaaah d’accord. Donc si vous êtes seul à vous faire cette réflexion c’est parce que personne n’a compris votre remarque super pertinente… Ah là là, c’est dur d’être lu par des nuls…

J’aime bien le coup du piratage à l’insu du possesseur d’iPhone… si on met des photos sur mon cloud à priori je devrais les voir et me rendre compte du piratage.. non?

Peut être parce que vous regardez vos photos tous les jours ,mais d autres non

Il suffira de ne pas installer iOS 15