Apple développe SceneScout, une IA de navigation pour les personnes malvoyantes

Apple et l’université Columbia ont dévoilé SceneScout, un prototype de recherche qui pourrait transformer la façon dont les personnes aveugles et malvoyantes naviguent dans leur environnement. Cette technologie exploite l’intelligence artificielle pour décrire de manière interactive les images de rue, offrant une assistance précieuse avant même de se déplacer.

Un besoin d’accessibilité encore mal adressé

Les personnes aveugles ou malvoyantes peuvent hésiter à voyager de manière indépendante dans des environnements inconnus, principalement à cause de l’incertitude concernant le paysage physique qu’elles vont rencontrer. La plupart des outils actuels se concentrent sur la navigation en temps réel, tandis que ceux qui proposent une assistance pré-voyage se limitent généralement aux points de repère et aux instructions détaillées.

Les images de vue de rue, pourtant riches en informations visuelles et capables de révéler de nombreux détails environnementaux, restent largement inaccessibles aux personnes aveugles et malvoyantes. SceneScout tente de combler cette lacune importante.

Une approche combinant les cartes et l’IA

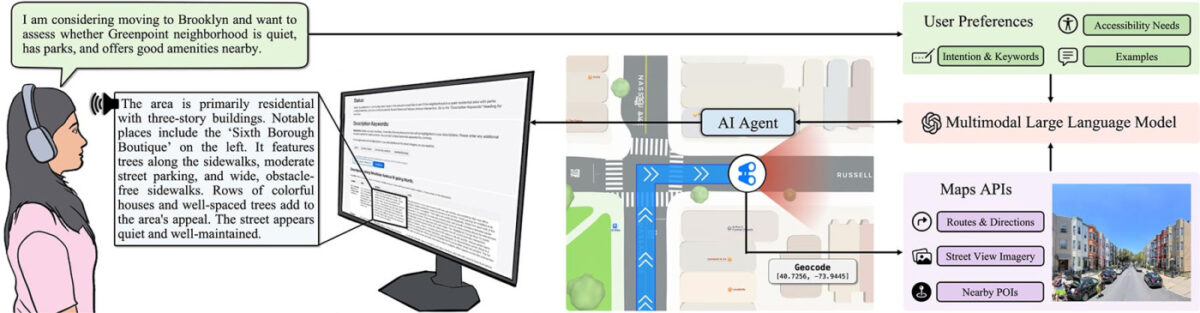

Les chercheurs ont développé un système qui combine les API d’Apple Plans avec un modèle de langage multimodal de grande taille. Cette approche permet de générer des descriptions interactives et personnalisées des images de vue de rue.

Au lieu de se contenter d’indications directionnelles ou de points de repère, les utilisateurs peuvent explorer un itinéraire complet ou découvrir virtuellement un quartier bloc par bloc. Les descriptions au niveau de la rue sont adaptées aux besoins et préférences spécifiques de chaque utilisateur.

SceneScout propose deux modes principaux d’interaction :

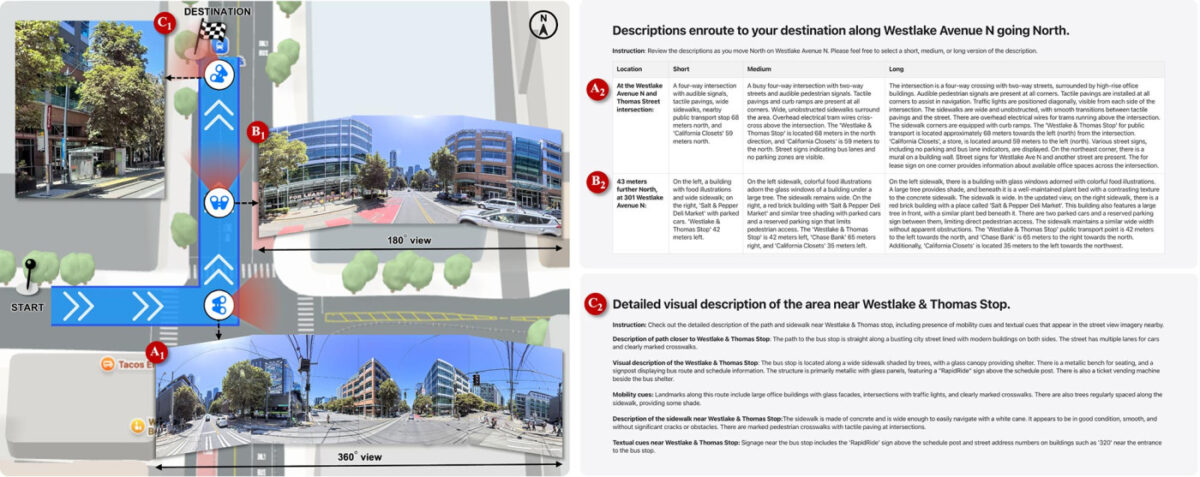

- Aperçu d’itinéraire : ce mode permet aux utilisateurs d’anticiper ce qu’ils rencontreront le long d’un chemin spécifique. Le système décrit la qualité des trottoirs, les intersections, les repères visuels, l’apparence des arrêts de bus et autres éléments pertinents pour la navigation.

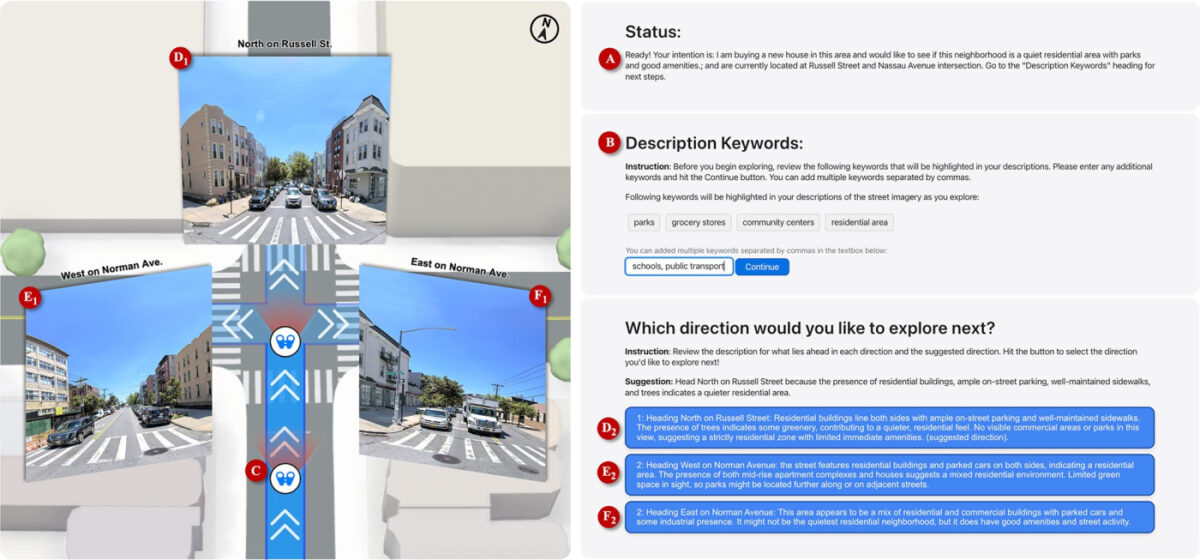

- Exploration virtuelle : plus ouverte, cette fonctionnalité permet aux utilisateurs de décrire ce qu’ils recherchent, comme « un quartier résidentiel calme avec accès aux parcs ». L’IA les aide ensuite à naviguer aux intersections et à explorer dans toutes les directions en fonction de cette intention.

Une technologie sophistiquée en arrière-plan

Le système utilise un agent basé sur GPT-4o ancré dans des données cartographiques réelles et des images panoramiques d’Apple Plans. Il simule la vue d’un piéton, interprète ce qui est visible et produit du texte structuré sous forme de descriptions courtes, moyennes ou longues.

L’interface Web, conçue spécifiquement pour les lecteurs d’écran, présente toutes ces informations dans un format entièrement accessible.

L’équipe de recherche a mené une étude avec 10 utilisateurs aveugles ou malvoyants, la plupart maîtrisant les lecteurs d’écran et travaillant dans le secteur technologique. Les participants ont testé les deux modes et ont attribué des notes élevées à l’expérience en termes d’utilité et de pertinence.

Le mode d’exploration virtuelle a particulièrement été salué car il donne accès à des informations que les utilisateurs doivent habituellement demander à d’autres personnes.

Quelques limites pour l’instant

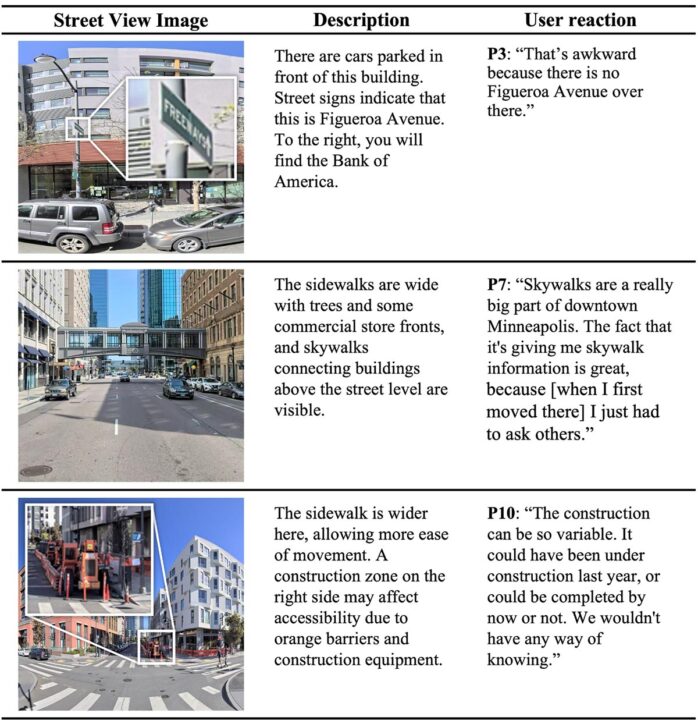

Malgré ces résultats encourageants, certaines lacunes importantes ont été relevées. Environ 72 % des descriptions générées étaient précises, mais certaines incluaient des hallucinations subtiles. Par exemple, le système affirmait parfois qu’un passage piéton disposait de signaux audio alors que ce n’était pas le cas, ou étiquetait mal certains panneaux de signalisation.

Bien que la plupart des informations restaient stables dans le temps, quelques descriptions référençaient des détails obsolètes ou transitoires comme des zones de construction ou des véhicules stationnés.

Les participants ont également souligné que le système faisait parfois des suppositions, tant sur les capacités physiques de l’utilisateur que sur l’environnement lui-même. Plusieurs utilisateurs ont insisté sur la nécessité d’un langage plus objectif et d’une meilleure précision spatiale, particulièrement pour la navigation des derniers mètres.

Vers une intégration temps réel

SceneScout n’est évidemment pas un produit commercial, mais il explore la collaboration entre un modèle de langage multimodal et l’API d’Apple Plans. Cette approche diffère de la navigation en temps réel basée sur la vision par ordinateur, mais pourrait facilement évoluer vers cette direction.

Les participants ont exprimé un fort désir d’accès en temps réel aux descriptions de vue de rue pendant la marche. Ils envisagent des applications qui diffusent des informations visuelles via des écouteurs à conduction osseuse ou un mode transparence pour fournir des détails pertinents pendant le déplacement.

Comme l’explique un participant : « Pourquoi les cartes ne peuvent-elles pas avoir une capacité intégrée pour aider à fournir des informations détaillées sur ce que vous croisez en marchant ? ».

Les participants ont suggéré d’utiliser des descriptions encore plus courtes pendant la marche, ne mettant en évidence que les détails critiques comme les repères ou les conditions de trottoir. Des descriptions plus complètes pourraient être déclenchées sur demande lorsque les utilisateurs s’arrêtent ou atteignent des intersections.

Un autre participant a proposé une nouvelle forme d’interaction où les utilisateurs pourraient pointer l’appareil dans une certaine direction pour recevoir des descriptions à la demande, plutôt que d’avoir à aligner physiquement l’appareil photo de leur téléphone pour capturer l’environnement. Cette approche permettrait aux utilisateurs d’examiner activement leur environnement en temps réel, rendant la navigation plus dynamique et réactive.