Le test de ChatGPT Health avec les données d’Apple Santé se révèle désastreux

ChatGPT Health, la nouvelle fonctionnalité de santé d’OpenAI, vient de subir un revers médiatique retentissant après qu’un journaliste du Washington Post a mis à l’épreuve ses capacités d’analyse. En connectant dix années de données biométriques issues de l’Apple Watch à l’intelligence artificielle, le journaliste a obtenu un diagnostic cardiaque alarmant, totalement contredit par le corps médical.

Un diagnostic erroné et aléatoire par ChatGPT

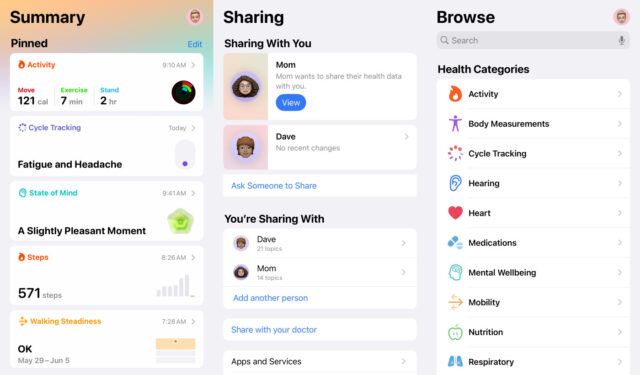

L’expérience menée par Geoffrey Fowler consistait à fournir à ChatGPT Health l’accès à un volume massif d’informations personnelles : 29 millions de pas et 6 millions de mesures de fréquence cardiaque stockés dans l’application Apple Santé. Lorsqu’il a demandé au chatbot d’évaluer sa santé cardiaque, l’IA lui a attribué la note désastreuse de F. Inquiet, le journaliste a consulté son médecin traitant, qui a immédiatement réfuté ce verdict numérique. Le praticien a confirmé que le risque cardiaque de son patient était si faible que les assurances ne couvriraient même pas des examens supplémentaires pour infirmer les dires du chatbot.

Plus inquiétant encore, l’outil s’est montré incapable de maintenir une cohérence dans ses analyses. En répétant la même question, les notes attribuées oscillaient brutalement entre un F et un B. Malgré un accès complet aux dossiers médicaux, l’IA a également oublié des données fondamentales comme l’âge ou le sexe de l’utilisateur. De son côté, l’IA concurrente Claude d’Anthropic n’a guère fait mieux avec une note de C, échouant là aussi à contextualiser les limites des données fournies par la montre.

Les médecins alertent sur des conseils « sans fondement »

La réaction des spécialistes est sans appel. Le cardiologue Eric Topol, du Scripps Research Institute, qualifie l’analyse de ChatGPT de « sans fondement » et estime que cette technologie n’est clairement pas prête pour le grand public. Il met en garde contre les dangers potentiels : ces outils risquent d’effrayer inutilement les utilisateurs sains ou, à l’inverse, de donner une fausse assurance à des personnes malades. Pour lui, si ces chatbots IA ne peuvent pas évaluer la santé avec précision, ils devraient s’abstenir de donner des notes.

Pourtant, la régulation américaine semble laisser le champ libre. La FDA (Food and Drug Administration) a récemment déclaré vouloir « s’effacer en tant que régulateur » pour favoriser l’innovation, traçant une ligne rouge uniquement pour les revendications cliniques directes. OpenAI et Anthropic se défendent en affirmant ne fournir que de l’information et non des diagnostics, rappelant que leurs outils ne remplacent pas un docteur.

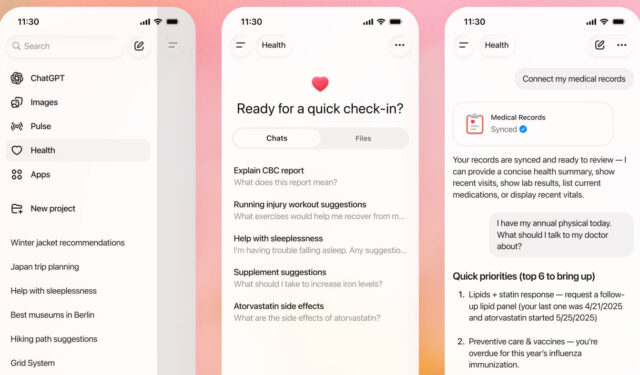

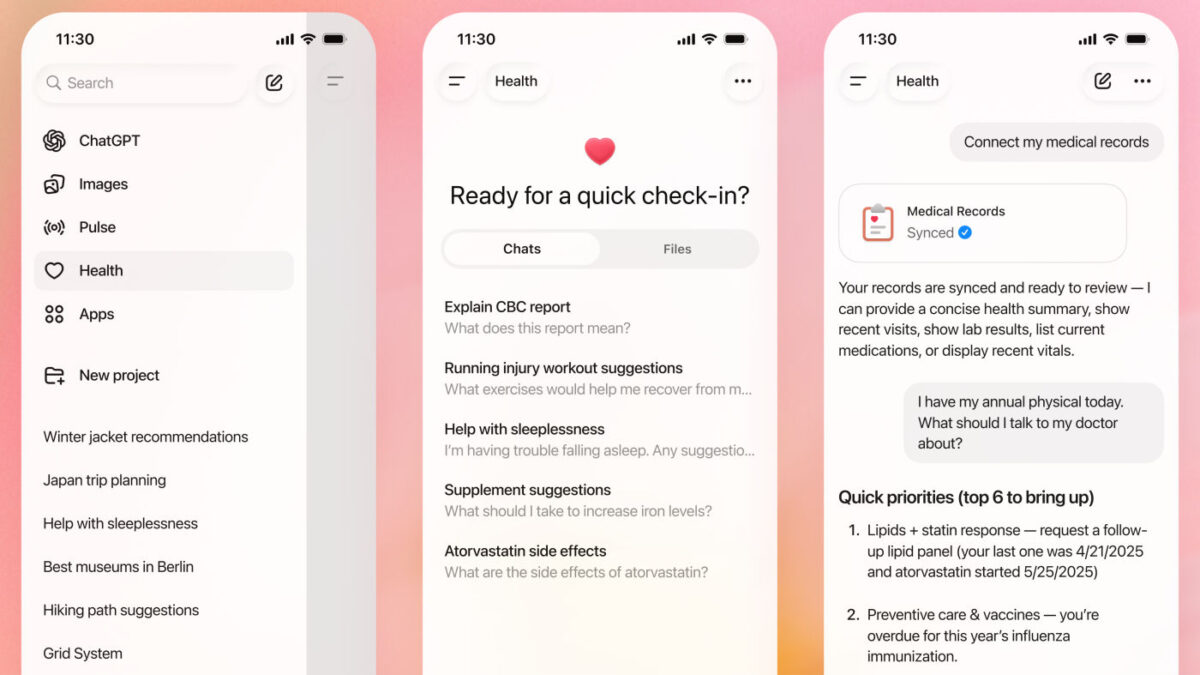

OpenAI a lancé ChatGPT Health plus tôt ce mois-ci comme une section dédiée et séparée, permettant l’intégration de services tiers comme MyFitnessPal, Peloton ou les dossiers médicaux pour personnaliser les réponses. Face à ce rapport accablant, l’entreprise a réagi par la voix de sa vice-présidente Ashley Alexander. Elle précise que l’accès est pour l’instant restreint à une liste d’attente justement pour « apprendre et améliorer l’expérience » avant un déploiement généralisé, promettant de travailler sur la cohérence des réponses.