L’analyse des photos d’utilisateurs par Apple est critiquée par des chercheurs en sécurité

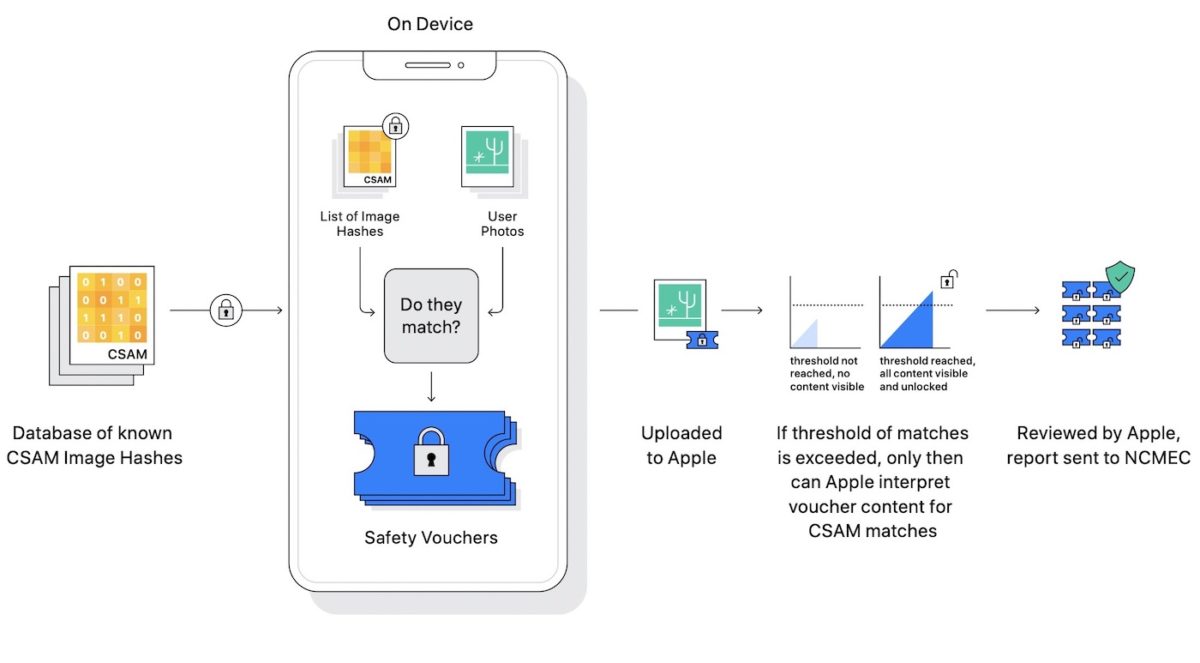

Apple a annoncé hier son intention d’analyser les photos des utilisateurs afin de voir s’il n’y a pas de contenu pédopornographique. Les photos des utilisateurs seront comparées avec une base de données qui recense des images d’abus sexuels sur les enfants. En cas de contenu qui correspond, Apple préviendra les autorités et fermera le compte iCloud de l’utilisateur. Mais pour des chercheurs en sécurité, Apple va trop loin.

La fausse-bonne idée d’Apple ?

Matthew Green, chercheur en cryptographie à l’université Johns Hopkins, déclare que l’analyse des photos par Apple est une « très mauvaise idée ». Il explique que ce système pourrait à l’avenir s’étendre à l’analyse des photos chiffrées de bout en bout plutôt qu’au seul contenu présent sur iCloud. Pour les enfants, Apple met en place une fonction d’analyse distincte qui recherche les contenus sexuellement explicites directement dans iMessage, à savoir sa messagerie qui est chiffrée de bout en bout.

Un autre élément évoqué par le chercheur en sécurité est le système de hachage qu’Apple va utiliser pour comparer les photos avec la base de données. Matthew Green note que des utilisateurs pourraient envoyer des photos qui n’ont aucun rapport avec la pédopornographie et le hachage pourrait mal faire son travail, impliquant des faux positifs. Pour sa part, Apple assure que son mécanisme offre « un niveau de précision extrêmement élevé ».

Pour Matthew Green, Apple a ouvert la boîte de pandore. Il pense que les gouvernements ne vont pas hésiter à demander à scanner certains contenus d’utilisateurs.

Les chercheurs en sécurité sont d’accord entre eux

Alec Muffett, un chercheur en sécurité qui a travaillé chez Facebook, pense que l’analyse des photos d’utilisateurs par Apple est « un pas énorme en arrière pour la confidentialité individuelle ». Il ajoute : « Apple fait marche arrière sur la vie privée pour permettre 1984 ». Il fait référence à Big Brother du roman 1984 de George Orwell.

Ross Anderson, professeur d’ingénierie de la sécurité à l’université de Cambridge, partage un point de vue similaire. C’est une « idée absolument épouvantable » pour lui qui pourrait conduire à « une surveillance massive distribuée ».

La méthode d’Apple pour analyser les photos des utilisateurs crée donc un débat. Mais certains rappellent que les autres entreprises technologiques le font déjà, là encore pour lutter contre la pédopornographie. Facebook a commencé en 2011. Ce fut encore plus tôt pour Google, à savoir 2008.

L’analyse par Apple débutera cet automne avec iOS 15.

Merci d’expliquer un peu mieux le procédé car dans l’article précédent on peut voir que les gens sont pas capables de comprendre ce qui est expliqué et de suite ça part dans des délires de flicage.

Heu excusez moi mais l article parle surtout de personnes spécialisées dans la recherche et sécurité informatique

Justement relis l’article et lis les inquiétudes. Les faux positifs qui peuvent ouvrir ton tel du coup, les dérives que cela pourrait engendrer etc. Donc dire que c’est une porte ouverte au flicage n’est pas du délire. Quand tu vois le scandale avec pegasus, le système d’Apple à terme aura les mêmes conséquences. Exemple en Chine, une caricature de xi-jinping et bim te voilà arrêter. Questionnes toi sur ce que ça peut amener à terme.

C’est vrai que la caricature de xi-jinping elle fait partie de la base de données des photos à caractère pédopornographique !

Même si c’est pour la bonne cause plein de dérive ont commencé sous fond de bonne cause

Personne ne l’a ouvert quand c’est Facebook ou Google qui l’ont fait, on attend que ce soit au tour d’Apple pour critiquer… parce que c’est Apple !????

Vous rigolez sans doutes sur le fait que Google et Facebook analysent toutes vos données sans que ça soulève des polémiques,surtout ici.

Par contre ce serait intéressant de connaître le résultat de cette surveillance par rapport aux affaires judiciaires d un côté et économique de l autre

Des facades d’ immeubles sont mis en publicité pour la confidencialité par Apple.

Là tout s’écroule, on débute par un thème qui plait aux Usa, la pédophilie…mais la vente d’arme, la violence dans les jeux, dans les séries…tout est permis.

L’IA averti Apple de nutité enfantine…oui mais, juste les photos ? les vidéos n’existent pas ?

Pour le contrôle du travail de l’IA, c’est un employé humain qui a accès à votre compte iCloud.

Il y a possibilité d’utiliser son iPhone sans compte iCloud ? Cette techno est juste du traçage de masse.

Aux dernieres nouvelles google ne scan pas les photos qui sont sur mon gdrive.

Car niveau faux positif tout les parents sont des pedo en puissance avec les photos de nos bambins parfois en tenue tres legere.

Les seuls coinces de la rondelle c est facebook qui censure 90% des statues du Vatican ou un nu du louvre . Bon faut dire facebook et culture…

Nan mais je ne comprends pas. Qui est forcé de déposer ses fichiers sur le cloud ? En quoi ce serait un droit de louer des espaces de stockages que personne ne pourrait consulter, quelles que soient les circonstances et les crimes ou délits commis par ce moyen ? Tout le monde part du principe que le droit à la vie privée implique le droit au secret et à l’anonymat sur internet : Bullshit

Oui et non .A ce moment on ne peut plus utiliser les termes de discrétion,anonymat,cryptage et protection comme valeur économique.

Ce sont les criminels qui ont le droit à la vie privé..Apple ont refusé de débloquer leurs iphone.

Pas de sex d’enfants c’est juste, mais alors pourquoi de la violence, de la torture, du sex dépravé, des meurtres dans SEE mis en avant par Apple, Aucune senction pour la vente d’armes qui pourtant, tue des dizaines d’étudients chaque année aux Usa. Et les jeux violents ? eux sont permis, mais un sein dénudé permet pas la mise sur l’Appstore ? On vit quoi là ? il y a un gros soucis

Aux États Unis le sexe c’est mal, la violence et les armes c’est bien. Un bon exemple est la polémique autour de la dernière vidéo du JdG

C’est une très mauvaise idée et c’est extrêmement dangereux. La dérive authoritaire et de principe culturel est grosse ici. Faut rappeler que au États-Unis on essaie de sensurer toutes nudité (adulte bien sûr), par bien-pensence et l’idéologie « woke »