La M1 Ultra n’est pas plus puissante que la Nvidia RTX 3090, malgré les sous-entendus d’Apple

Au moment de présenter son Mac Studio avec la M1 Ultra, Apple a proposé des graphiques avec notamment une comparaison entre sa puce et la carte graphique RTX 3090 de Nvidia, assurant que son modèle était plus performant. Mais ce n’est pas le cas dans les faits.

La RTX 3090 reste meilleure que la M1 Ultra

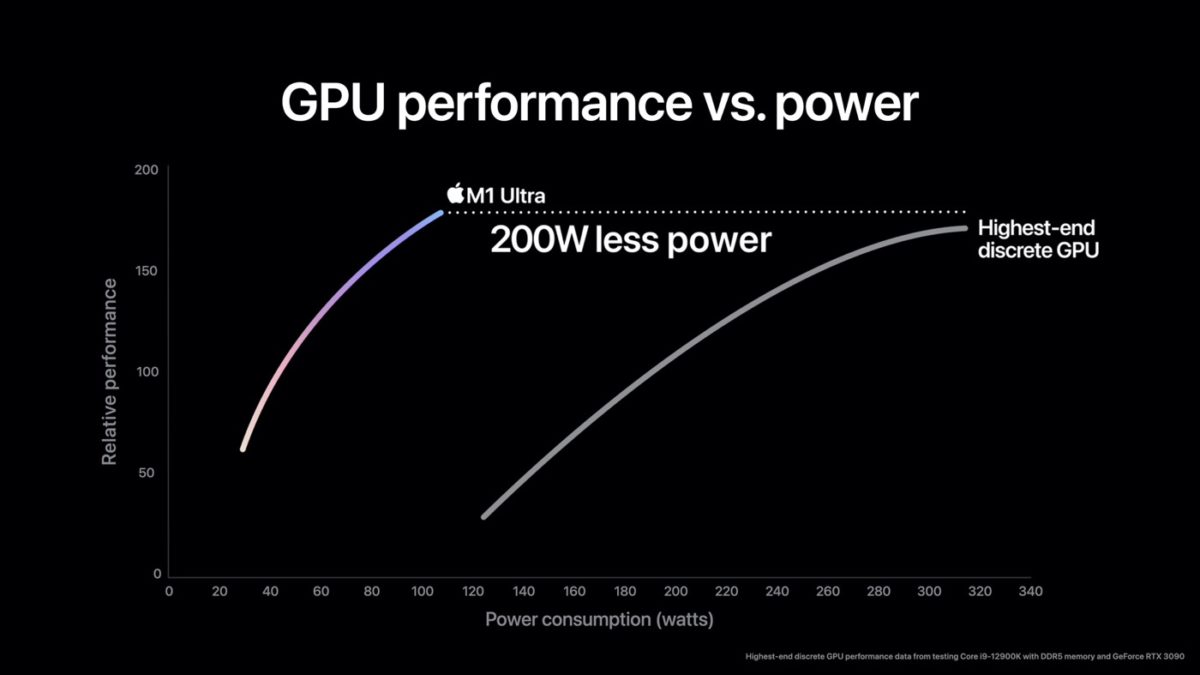

Dans son graphique, Apple suggère que la puce M1 Ultra arrive à être un peu plus puissante que la RTX 3090 de Nvidia, tout en consommant 200 W de moins. Mais le problème est que la méthodologie utilisée n’est pas communiquée. The Verge a donc mené ses propres tests avec Geekbench et la carte graphique de Nvidia s’en sort bien mieux.

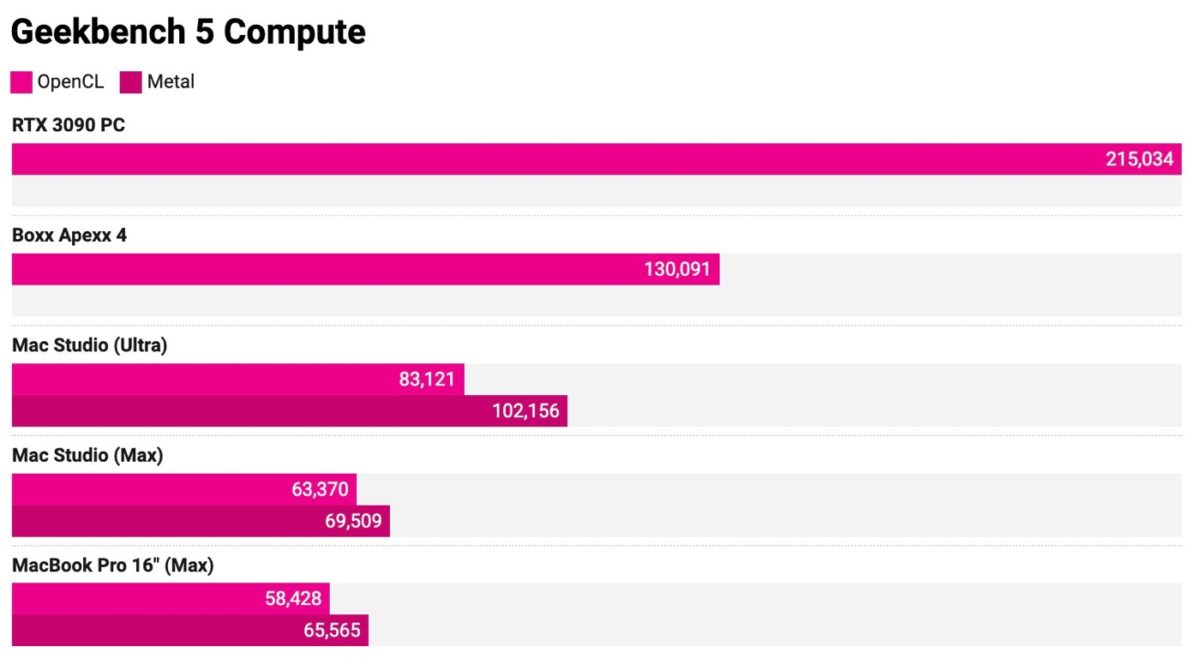

Le score obtenu avec la RTX 3090 au benchmark est de 215 034, contre 83 121 (avec OpenCL)/102 156 (avec Metal) pour le Mac Studio équipé de la M1 Ultra. C’est deux fois moins donc. Cela ne veut pas dire que la puce d’Apple est mauvaise, pas du tout même. C’est seulement que la carte graphique de Nvidia est beaucoup plus performante.

Il est vrai que l’annonce d’Apple lors de la keynote avait un peu surpris. Le fait qu’une puce arrive à faire mieux qu’une carte graphique dédiée serait plus qu’étonnant, du moins en 2022. Voici ce que note The Verge :

Il semble qu’Apple ne montre tout simplement pas toutes les performances du concurrent qu’il pourchasse ici.

C’est un peu comme si vous disiez que parce que votre voiture électrique consomme beaucoup moins de carburant à 130 km/h qu’une Lamborghini, elle a un meilleur moteur — sans mentionner le fait qu’une Lamborghini peut quand même aller deux fois plus vite.

Pour rappel, la M1 Ultra est plus ou moins l’équivalent de deux puces M1 Max que l’on regroupe. Les tests montrent que les performances ont effectivement doublé (ou presque) avec la puce très haut de gamme que l’on retrouve dans le Mac Studio. Ce modèle est disponible à l’achat depuis aujourd’hui.

Et un mensonge de plus…Et les watt consommées en pleine puissance de la double M1 risque de pas être si loin des 200w… connectéau secteur pas de soucis, mais du montage 4k sur Mac pro diminue l’autonomie annoncée de moitié…les 15w sont lourd 😁

Une rtx 3090 + CPU + CM + SSD + RAM ça consomme largement plus que 200w … tu es plus dans les 450-500w Apple à jouer sur les mots mais à conso identique le Mac enfonce le pc que je cite ( sans être fanboy )

Les benchmarks veulent tout et rien dire, il faut voir l’utilisation réelle comme j’ai dit et ne t’inquiète pas que les iPhones sont connus pour fumer tes Androids, tant sur les performances que sur l’autonomie :).

Et ? On parle aussi uniquement de la consommation du M1. Il n’est en rien indiqué la consommation du reste.

Bonnet blanc, blanc bonnet…

Non, le M1 Ultra ne fera pas 200 W. L’important à noter ici, c’est qu’Apple est arrivé à un tel niveau de performances sur un GPU intégré qu’on soit obligé de débunker ses comparatifs exagérés avec le plus puissant de GPU dédiés de NVidia. Mettre ça au niveau d’un « mensonge » c’est se tromper d’analyse. Il ne serait venu à l’idée de personne qu’un jour un GPU intégré soit aussi puissant qu’une carte graphique haut de gamme. Le M1 Ultra en est pourtant là (21 tflops).

21Tflops c’est +/- une RTX 3070Ti tout de même, carte qui affiche un TDP de 290W. Une carte qui permet de jouer en 4K sans réels problèmes (sans activer les DLSS). Moi je dis bravo.

C’est plutôt en activant le ray tracing et le dlss que cette CG permet de jouer convenablement en 4K.

Par contre il y a un truc inconsistant avec les résultats GeekBench: le M1 Ultra est censé être exactement 2x le Max.

Pourtant on est extrêmement loins d’un 2x dans ces résultats. Peut-être GeekBench est simplement pas optimisé?

J’avais vu sur une chaine YouTube ce que vous dites, et il semblerait que la M1 Ultra, tout comme la M1 Max d’ailleurs à l’époque, ne donnent pas toute leur puissance sur un test si court que Geekbench. Quand bien même, il faudrait plutôt voir en utilisation réelle ce que cela donne, et écrire cet article avec un tel titre sur un pauvre benchmark… C’est mensonger tout simplement. Ensuite comme les autres M1, l’Ultra souffrira de ce qui n’est pas encore optimisé à son architecture, et on pensera à tort que les Nvidia sont plus rapides alors que pas du tout quand on connaît l’arrière du décor. Rosetta 2 fait un travail remarquable, mais elle atteint ses limites au fil de la puissance, la traduction freine d’une part encore plus importante que l’on augmente la puissance. Il faudrait réellement travailler avec la nouvelle architecture pour libérer ce que renferme les M1.

Be prend 2 cartes graphique en SLI tu penses avoir 200% de puissance ben non.

Tout est histoire de bande passante.et de goulets aux niveau des divers bus.

Ce n’est pas une carte graphique, c’est un gpu intégré déjà. Ensuite le pont Ultrafusion est si performant que 2 M1 Max font bien 2x plus de performances, quasiment, sur ce benchmark cela ne se voit pas pour les raisons que j’ai cité plus haut, mais cela se verra en utilisation réelle.

Oui, il y a un manque d’opti ici. La puissance réelle est de 21 tflops sur le GPU intégré et il y de fortes chances que les jeux testés pour le bench prennent mal en charge la configuration particulière du M1 Ultra (et c’est encore pire bien sûr pour les jeux sous Rosetta). Il n’y a rien à changer sur le code pour les calculs en CPU, pas sûr qu’il en soit de même pour la partie GPU.

C’est reparti pour être dépassés vite fait… Et à quoi bon payer si cher sans écran.

Les bureaux Pixar par exemple sont installés de Surface Studio, qui porte vraiment son nom, ici on doit compléter pour du fonctionnel à coup de $$

méme les surfaces Pro tirent leur épingle dans les médias pouvant annoter à la volée pour 1/2 prix, sans la puissance de ces Macs Studio cantonnés aux bureaux devant y connecter moultes périfs pour égaler la Surface Studio qui fonctionne depuis 4 ans avec des évolutions déjà en modèles upgradés

pro ou studio de met pas par mode…..

Tu sais le monde avance, et c’est pas avec tes chromebooks qu’il le fera. Apple lance et impose la nouvelle architecture ARM sur ordinateur, parce qu’il est plus que temps d’arrêter avec les grille-pains d’intel, qui ne gagnent en performances qu’en faisant grimper la facture d’électricité on a l’impression… Alors oui pour l’instant rien est optimisé, mais tu verras plus tard quand ça le sera, tout le monde dira merci Apple, comme ce fut le cas avec l’iPhone.

Il n’y a pas de mensonge ni de sous entendu.

Malgré la mention de la présence d’une RTX 3090 dans la configuration, il est précisé très clairement sur le graphique que la comparaison est faite avec la partie graphique intégrée d’un core i9-12900k.

Maintenant, on ne parle pas de carte optimisée pour le jeu ou l’IA, mais pour l’édition photo/vidéo principalement. Une comparaison d’usage serait plus intéressante.