Pédopornographie : Apple annule son projet d’analyser les photos des utilisateurs

Le projet controversé d’Apple consistant à analyser les photos des utilisateurs pour lutter contre la pédopornographie est abandonné. En effet, la société annonce qu’il ne verra finalement pas le jour.

Voici ce qu’Apple annonce dans un communiqué :

Après une vaste consultation d’experts visant à recueillir des commentaires sur les initiatives de protection de l’enfance que nous avons proposées l’année dernière, nous approfondissons notre investissement dans la fonction de la sécurité des communications que nous avons mise à disposition pour la première fois en décembre 2021. Nous avons en outre décidé de ne pas aller de l’avant avec l’outil de détection CSAM proposé précédemment pour les photos iCloud. Les enfants peuvent être protégés sans que les entreprises passent au peigne fin les données personnelles, et nous continuerons à travailler avec les gouvernements, les défenseurs des enfants et d’autres entreprises pour aider à protéger les jeunes, à préserver leur droit à la vie privée et à faire d’Internet un endroit plus sûr pour les enfants et pour nous tous.

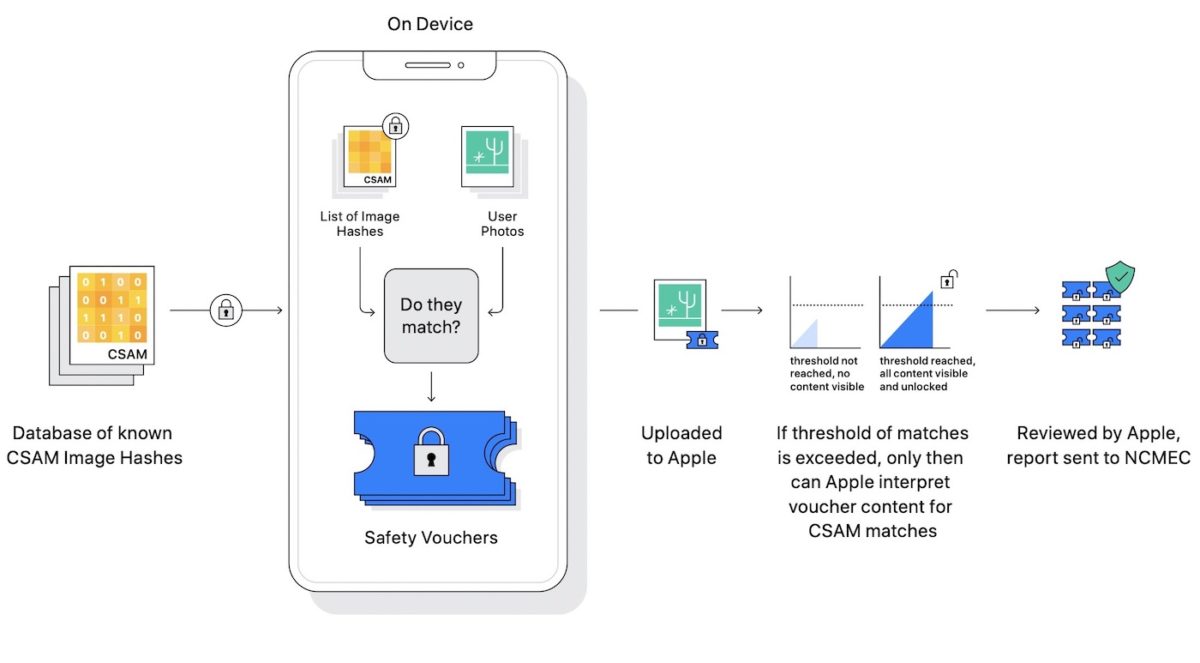

Lorsque l’analyse des photos a été annoncée, Apple a déclaré qu’iCloud serait en mesure de détecter les contenus inappropriés dans les photos des utilisateurs en se basant sur une base de données de hash d’images (CSAM). De cette façon, la société serait en mesure de détecter de telles photos à l’aide d’un traitement sur l’appareil, sans jamais avoir à voir les photos des utilisateurs. Comment ? Chaque image a son propre hash.

Il se trouve que cette fonctionnalité a dérangé beaucoup de personnes, estimant qu’Apple n’a pas à faire une telle analyse. Beaucoup ont critiqué le fait qu’Apple vante le respect de la vie privée en temps normal, au point d’avoir presque un double discours avec l’analyse. Voilà maintenant que le projet est enterré.

C est étonnant quand même, le fonctionnement garantie la vie privée, seulement pas pour les personnes qui ont des images pedo quoi au final.

Je trouve ça surprenant la grogne des utilisateurs a ce sujet. Une incompréhension du fonctionnement peut être.

Non les gens ont bien compris, ils ´ne veulent juste pas qu’on fouille leur téléphone de quelque façon que ce soit. Contrairement à toi

Bien dit

Justement il ne s’agit pas des téléphones mais des data center d’Apple. Les gens ne sont pas représentés par les 3 teubés qui gueulent plus fort et qui se croient doués d’un droit naturel au secret absolu de tout ce qu’ils portent sur iCloud (et qui pensent en plus que c’est plus important que la lutte contre la pédo-criminalité). J’espère que vous êtes juste les plus bruyants, pas les plus nombreux.

C’est vrai qu’en rayon teubé tu trouves toute ta place. Le contenu de mon Cloud ne regarde que moi et moi seul. Les limités dans ton genre qui pensent généraliser leur ignorance et étaler leur vie privée sont assez nombreux hélas. Tu pourras demander à Apple qu’ils scannent ton Cloud cela devrait te satisfaire

Je te confirme que comme le reste de la planète, je me cogne totalement de ton Cloud et de tes secrets d’ado boutonneux. L’intelligence ça ne s’achète pas mais une clef USB oui, et tu devrais le faire parce que si tu crois que tes données sont protégées chez Apple tu es aussi très naïf. Une qualité de plus champion

Il faudrait expliquer aux gens ce qu’est un HASH, c’est l’inculture scientifique de notre société qui in fine fait prendre les mauvaises décisions. Les gens sont bêtes et n’ont aucun sens du libre arbitre, ils ne cherchent pas à analyser à comprendre.

Oui, c’est toujours pareil…

N’importe quoi ce que tu raconte.

Sur le principe je suis d’accord avec toi : Ce n’est qu’un Hash donc il compare avec des hach de photo pdporn*phique qu’ils ont dans une grande base de donnéC’est très bienLe problème c’est le détournement d’intention : qui te dit qu’il ne vont pas mettre des hash n’ayant rien à voir avec la pedoogra**ie Une adoration pour le FN ? Pour Macron? Pour melanchon ???Tu as des photos vidéo (enfin les hash) de Bigard DieudonnéOn te ficherais bien S pour si peu de chose dorénavant en France et c’est bien là le problème c’est la dérive que peuvent en faire les gens

Toujours pas non. On a compris et on ne veut pas :)

Va falloir t’y résoudre

Oh oui t’as tout compris toi. Ca se vois que tu es doté d’une intelligence supérieure avec tes posts très profond…

Ho la la ! il y en n’a qui ce prenne pour de vrai bêtes ;)

Apple annule son programme de lutte contre la pédopornographie, Apple adapte son système pour améliorer la répression chinoise, Apple est une entreprise engagée qui est prête à vendre sa mère pour un peu de tunes

La grogne de toutes les classes politiques, les dépravés hollywoodiens et autres supers riches qui n’ont aucune limite. En fait pour protéger les élites, ils reculent au détriment de milliers de prédateurs. Rien à voir avec les donnés personnelles qui sont déjà tellement a mal par les états et autres services de surveillances… Je sais pas si vous vous êtes rendus compte depuis l’acceptation ou non des cookies le nombre anarchique de personnes pouvant accéder à votre profil. Bref, quand on annule un tel accessoire c’est que ça dérange… et pas le commun des mortels.

Le souci c’est qu’il s’ajoute au petit nombre de pédo-malades une cohorte de gosses autocentrés qui n’ont pour seul objectif que la défense d’un droit autoproclamé au secret de leurs petites vies misérables, peu importe les autres, les prédateurs, les gosses violés, etc…

Ça a dû jaser en haut lieu, très vite ils se seraient rendu compte du nombre de leurs actionnaires qui des criminels