IA : Apple supprime des applications de l’App Store qui génèrent des images de nudité

Apple a décidé de supprimer plusieurs applications de l’App Store qui utilisent de l’intelligence artificielle pour générer des images de nudité. Ce retrait a eu lieu une fois que la société a appris par 404 Media que les apps étaient utilisées pour déshabiller des femmes.

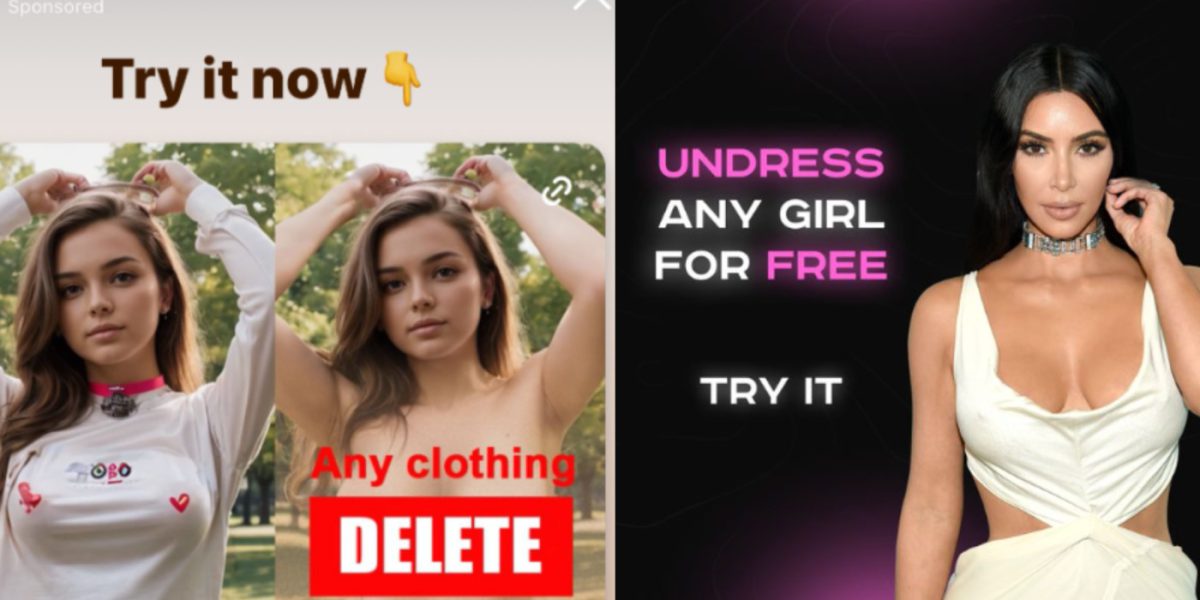

Tout est parti d’une enquête explorant la façon dont des entreprises utilisent la publicité sur Instagram pour promouvoir des applications qui peuvent « déshabiller n’importe quelle fille gratuitement ». Certaines de ces publicités Instagram conduisent les utilisateurs directement sur l’App Store pour une application qui y est décrite comme un « générateur d’art ».

404 Media a d’abord prévenu Apple, mais la société n’a pas réagi. Elle a finalement répondu une fois que le média a publié son article. Elle a notamment demandé davantage d’informations, comme les noms et les liens App Store des applications. Une fois les informations obtenues, Apple a retiré de l’App Store les applications utilisant l’IA pour générer des images de nudité.

Il y a fort à parier qu’Apple devra faire face à d’autres applications de ce type à l’avenir, étant donné que les outils d’IA deviennent de plus en plus populaires et accessibles. La preuve, le fabricant n’avait rien remarqué de particulier en approuvant la première fois les différentes applications qui sont aujourd’hui supprimées. Et encore, le retrait a eu lieu parce qu’Apple a reçu une alerte par un tiers.

(Mode humour sarcastique sur on) Pas besoin de s’inquiéter ! En Europe, avec le DMA, on est tranquille, on pourra toujours les avoir. Merci qui ? Jackie et Michel de la commission européenne !(Mode humour sarcastique sur off) 😂

mdr +1

Et les entreprises qui le font en seront responsables aussi