Apple explique pourquoi FaceTime propose des sous-titres plutôt qu’une traduction audio

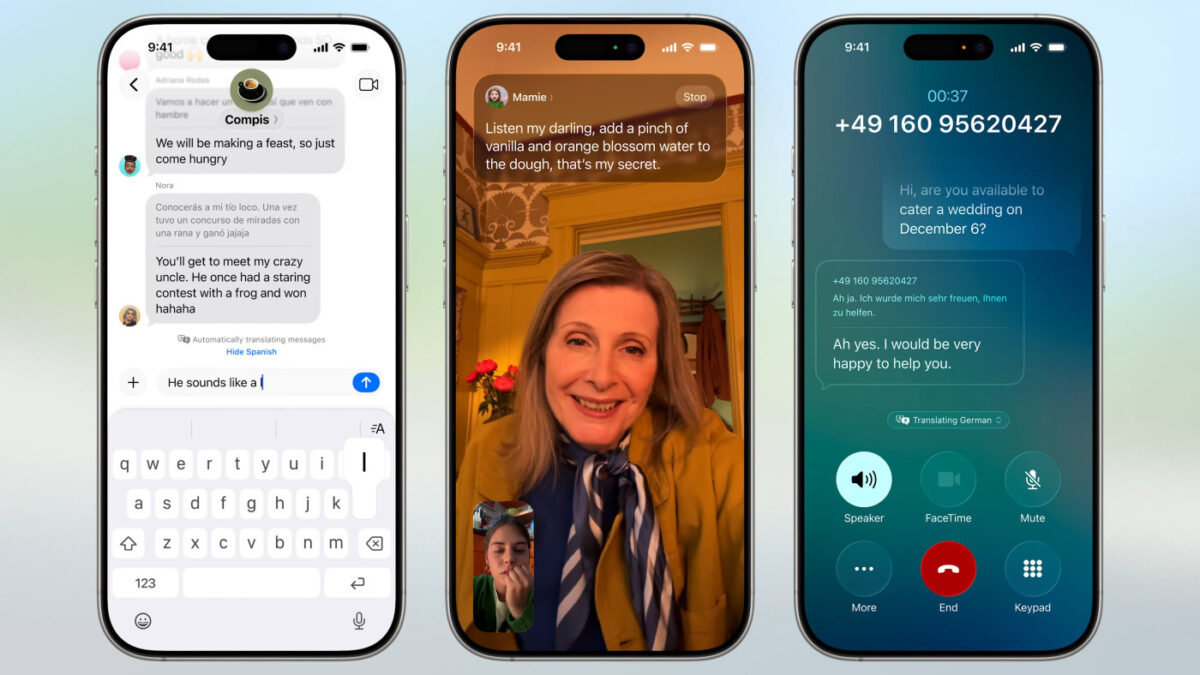

La traduction en direct est disponible en Europe avec les AirPods depuis iOS 26.2. On a ainsi la traduction audio quand quelqu’un parle une autre langue. Mais sur FaceTime, la traduction passe par des sous-titres. Pourquoi ce choix ?

Des sous-titres pour la traduction en direct sur FaceTime

Areeba Kamal, une responsable produit de l’intelligence artificielle chez Apple, a répondu à cette question lors d’une interview avec Le Figaro. Elle déclare :

Nous considérons FaceTime comme un outil pour communiquer avec des personnes proches, des amis ou des membres de la famille parlant une langue différente. Nous voulons que l’usager puisse voir la personne à qui il parle et qu’il perçoive vraiment chaque intonation, chaque rire dans sa voix, même s’il dispose en parallèle de sous-titres. En revanche, lors d’un appel téléphonique, ou en FaceTime audio, le système baisse le volume de la voix et monte celui de l’audio traduit. On reste ainsi conscient que la personne parle, de ses expressions, sans que cela soit distrayant.

Le reste de l’interview, qui se veut assez courte, n’apporte pas beaucoup d’informations qui n’étaient pas déjà connues pour tous ceux qui suivent l’actualité d’Apple. Ron Huang, vice-président de la connectivité chez Apple, explique par exemple que les modèles de traduction sont exécutés localement sur l’iPhone à l’aide d’Apple Intelligence. Il parle aussi des AirPods :

Nous avons aussi dû réaccorder les micros des AirPods pour qu’ils captent l’audio lointain. Après des années passées à les optimiser pour supprimer le bruit environnant et permettre des appels téléphoniques propres, nous avons fait l’opération inverse pour capter les voix des personnes autour de l’utilisateur.

Areeba Kamal ajoute un usage intéressant des iPhone sans Apple Intelligence :

Nous avons développé beaucoup de technologies intéressantes pour donner vie à tout cela. Par exemple, quand vous utilisez la traduction en direct dans l’application téléphone, vous pouvez appeler quelqu’un avec un iPhone plus ancien, un smartphone d’une autre marque ou même une ligne fixe. Grâce à Apple Intelligence et Live Translation, les deux parties de la conversation peuvent suivre l’expérience de traduction orale.

D’autres langues sont être disponibles

Vient aussi le cas des langues prises en charge par la traduction en direct sur FaceTime. En l’état, 10 langues sont supportées. Apple va en ajouter d’autres avec le temps, mais cela demande du travail. « La préparation d’un langage requiert des centaines de milliers d’heures d’évaluation », reconnaît Areeba Kamal.

De son côté, Ron Huang dit qu’Apple a « collecté de vraies conversations dans des cafés, restaurants et différents environnements pour nous assurer que les données simulées représentent le monde réel ». Il ajoute que le fabricant a passé des « milliers d’heures à tester différentes positions de micros et de haut-parleurs. L’orientation du téléphone compte vraiment pendant la séance de traduction. Nous utilisons à la fois le microphone des AirPods et celui de l’iPhone, privilégiant celui qui capte le mieux la parole ».