[MaJ] Apple retire de son site toutes les références au CSAM, son outil anti-pédopornographie très controversé

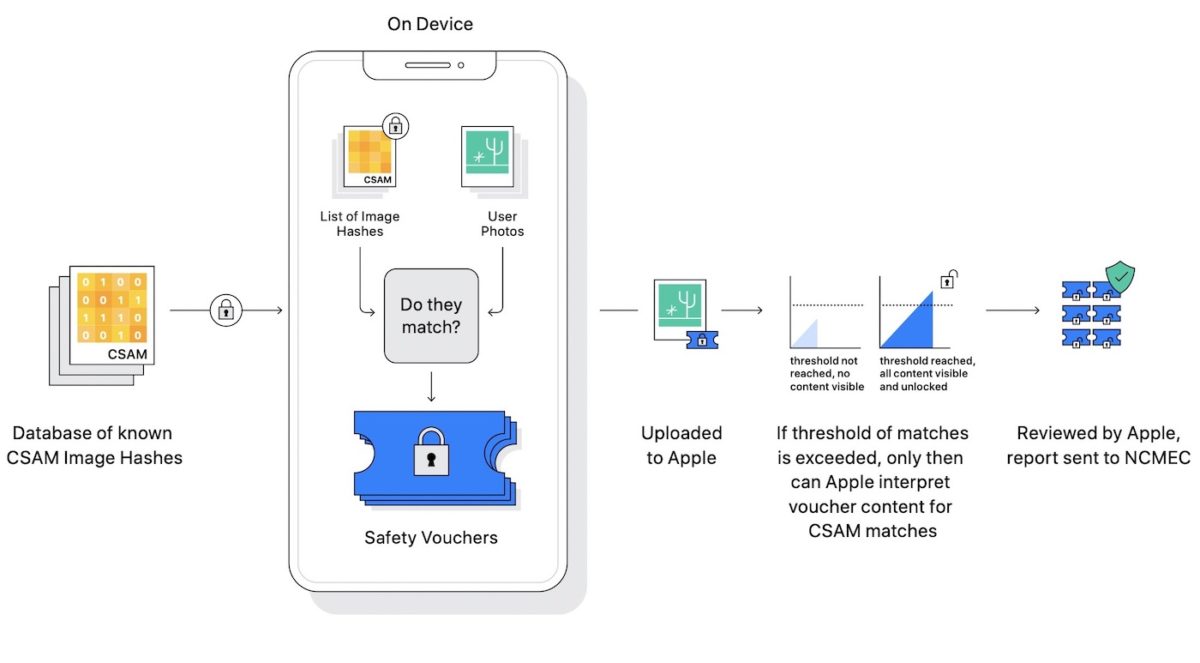

Apple semble avoir tourné la page du CSAM, son outil de scan des messages envoyés (sous iOS 15, iPadOS 15, watchOS 8, et macOS Monterey) permettant de repérer les clichés à caractère pédopornographiques, voire d’alerter « en douce » les autorités en cas de récidive d’envoi de ce type de clichés. L’annonce de cet outil avait généré une levée de boucliers de la part d’experts en sécurité informatique et de nombreuses associations de défense des consommateurs, des libertés individuelles et des droits civiques, avec pour point d’orgue un message angoissé du lanceur d’alerte Edward Snowden.

Face à la bronca, Apple avait fini par reporter le lancement de cette fonction de surveillance intégrée dans les OS sus-cités : « Sur la base des commentaires des clients, des groupes de défense des droits, des chercheurs et d’autres, nous avons décidé de prendre plus de temps au cours des prochains mois pour recueillir des commentaires et apporter des améliorations avant de publier ces fonctionnalités d’une importance critique pour la sécurité des enfants. »

Finalement, Apple aurait décidé d’effacer toute trace du CSAM : la fonction n’est plus mentionnée sur la page Apple dédiée à la protection des enfants, et on ne la trouve pas plus sur la page des mises à jour à venir. En fait, le CSAM a tout simplement disparu de l’ensemble des sites Apple partout dans le monde, comme si Apple ne l’avait jamais présenté.

MaJ du 15/12/2021 : suite au retrait de toute référence au CSAM, le porte-parole d’Apple Shane Bauer a tenu à préciser que la position d’Apple n’avait pas changé depuis septembre, c’est à dire depuis le communiqué précisant que la fonction serait reportée à plus tard. Dont acte.