[MàJ] iMessage : Apple va proposer au Royaume-Uni ses mesures pour lutter contre la pédopornographie

- Jean-Baptiste A.

- 20 Avr 2022à 20:25

- Actualité & avis iPhone / iPod

- 1 partages

- 9

- 4

Après les États-Unis avec iOS 15.2, ce sera au tour du Royaume-Uni d’avoir le droit aux mesures de prévention d’Apple pour iMessage afin de lutter contre la pédopornographie. Il n’y a pas encore de date pour la France ou les autres pays.

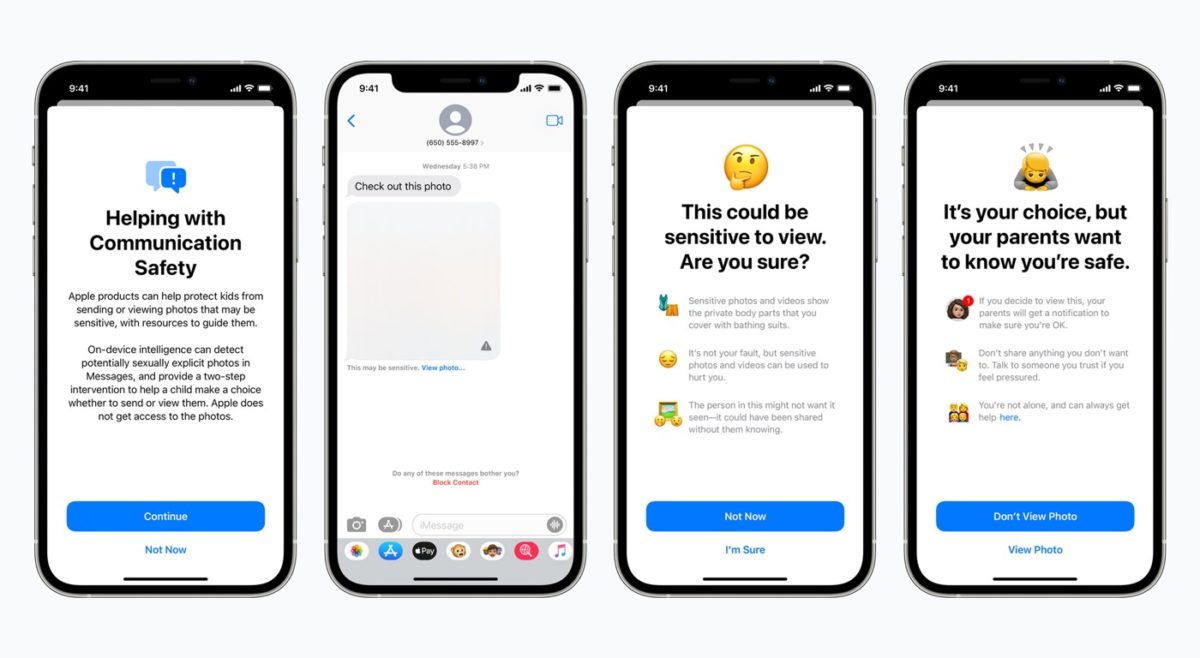

Les mesures d’Apple pour iMessage arrivent au Royaume-Uni

Avec le système d’Apple, une analyste des iMessages envoyés et reçus est réalisée afin de déterminer s’il y a de la nudité. C’est un moyen de prévenir les enfants afin qu’ils n’ouvrent pas ce type de contenu. Si la nudité est détectée dans une photo reçue par un enfant, la photo est floutée et l’enfant recevra des ressources de groupes de protection de l’enfance. La nudité dans une photo envoyée par un enfant déclenchera un avertissement encourageant l’enfant à ne pas envoyer l’image.

Ce sont les parents qui ont le contrôle sur cette fonctionnalité et peuvent l’activer (ou non) sur l’iPhone de leurs enfants. Au passage, la vérification de contenus ayant de la nudité se fait directement sur l’iPhone et non sur les serveurs d’Apple.

Selon The Guardian, les mesures de prévention d’Apple pour iMessage afin de lutter contre la pédopornographie vont être disponibles au Royaume-Uni d’ici quelques semaines avec une mise à jour. On peut imaginer que ce sera avec la version finale d’iOS 15.5. Cette version est actuellement disponible en version bêta, avec d’ailleurs la deuxième bêta qui a vu le jour hier pour les développeurs et aujourd’hui pour les testeurs publics.

Mise à jour du 21/04 : si l’on en croit nos confrères d’Apple Insider, la même technologie de floutage des photos de nus sera aussi bientôt disponible au Canada, en Nouvelle-Zélande et en Australie.

C’est une bonne lutte mais donc Apple voit nos photos et vidéos sur iMessage lorsque l’on parle avec nos correspondants ? Je me souviens qu’ils disaient que non mais je trouve cela limite, bien sûr il faut lutter contre cette criminalité immonde mais je ne suis pas serein de savoir mes conversations ainsi que médias scannés par Apple pour voir s’ils ressemblent à ce genre de média.

Par exemple le nombre de personnes qui s’envoient des nudes, vu qu’Apple scanne la nudité est-ce que leurs photos sont visionnées ? Va-t-on vers un contrôle absolu des médias dans nos messages. Si j’envoie une photo osée à celui que j’aime est-ce que la scanner can déceler de la nudité type enfant ? Comment peuvent-ils savoir ça m’effraie de voir qu’ils peuvent visionner nos médias sur iMessage sachant que oui il faut lutter contre ça a fond même mais donc ne pas compter sur iMessage pour les personnes s’échangeant des nudes en Europe, Amérique et bientôt au Royaume-Uni. Mais sachez que je suis pour les moyens contre la pedopornographie qui est un crime à m’en faire vomir.

Par exemple le nombre de personnes qui s’envoient des nudes, vu qu’Apple scanne la nudité est-ce que leurs photos sont visionnées ? Va-t-on vers un contrôle absolu des médias dans nos messages. Si j’envoie une photo osée à celui que j’aime est-ce que la scanner can déceler de la nudité type enfant ? Comment peuvent-ils savoir ça m’effraie de voir qu’ils peuvent visionner nos médias sur iMessage sachant que oui il faut lutter contre ça a fond même mais donc ne pas compter sur iMessage pour les personnes s’échangeant des nudes en Europe, Amérique et bientôt au Royaume-Uni. Mais sachez que je suis pour les moyens contre ce crime qui est un crime à m’en faire vomir.

Je pense que vous n’avez pas bien lu : « Ce sont les parents qui ont le contrôle sur cette fonctionnalité et peuvent l’activer (ou non) sur l’iPhone de leurs enfants. Au passage, la vérification de contenus ayant de la nudité se fait directement sur l’iPhone et non sur les serveurs d’Apple. »

Il n’y a pas de scan systématique si la fonction n’a pas été activée. Personne chez Apple ne voit vos photos vu que cela se passe en local sur le téléphone.

Après je n’invente rien je ne fais que reprendre ce qui est dit.

Apple ne voit pas les photos et vidéos, comme expliquer dans l’article et dans les captures d’écrans. Il s’agit d’un: « On-device intelligence can detect potentially sexually explicit photos in Messages, and provide a two-step intervention to help a child make a choice whether to send or view them. Apple does not get access to the photos.

Bientôt apple ce permettra de ce servir sur votre compte en bank !!!

Soit disant pour la sécurité

*

Moi c ce que je ferais, je dirais que c pour éviter les fraude fiscale allor je prendrai directement sur le compte en bank. C l’avenir apres tout (on n’ai plus maitre de nous mm)

Les scandales financiers viennent des US, en aucun cas de Chine…vite vu pour ces exemples…foncer vers Huawei…