ILuvUI, l’IA d’Apple qui comprend les interfaces d’applications

Apple présente ILuvUI, un modèle d’intelligence artificielle capable d’interpréter les interfaces des applications mobiles. Cette recherche, menée en collaboration avec l’université Aalto en Finlande, ouvre des perspectives prometteuses pour l’accessibilité et l’automatisation des tests d’interface.

Un défi majeur dans l’interaction homme-machine

L’équipe de recherche s’attaque à un problème complexe qui perdure depuis des années dans le domaine de l’interaction homme-machine (IHM). L’objectif consiste à enseigner aux modèles d’IA la capacité de raisonner sur les interfaces utilisateur de manière similaire aux humains. Cette approche combine à la fois la compréhension visuelle et sémantique des éléments d’interface.

Comprendre et automatiser les actions sur les interfaces représente un défi considérable. Les éléments d’interface comme les listes, les cases à cocher et les champs de texte contiennent plusieurs couches d’informations qui dépassent leur simple fonction interactive. Bien que les grands modèles de langage (LLM) excellent dans la compréhension d’instructions en langage naturel, leur utilisation avec des descriptions textuelles seules ignore l’information visuelle riche des interfaces.

Les limites actuelles des modèles vision-langage

Les chercheurs soulignent une limitation importante des modèles actuels. La plupart des modèles vision-langage sont entraînés sur des images naturelles comme des chiens ou des panneaux de signalisation. Par conséquent, leurs performances diminuent significativement lorsqu’ils doivent interpréter des environnements plus structurés comme les interfaces d’applications.

Cette situation créé un écart entre les capacités des modèles et les besoins réels. Les modèles vision-langage (VLM) acceptent des entrées multimodales combinant images et texte, mais leur performance sur les tâches d’interface reste inférieure à celle sur les images naturelles. Cette limitation provient principalement du manque d’exemples d’interfaces dans leurs données d’entraînement.

Face à ces contraintes, l’équipe a choisi de perfectionner le modèle open source LLaVA. Elle a également adapté sa méthode d’entraînement pour se spécialiser dans le domaine des interfaces utilisateur. Cette approche ciblée permet d’optimiser les performances sur des tâches spécifiques aux interfaces mobiles.

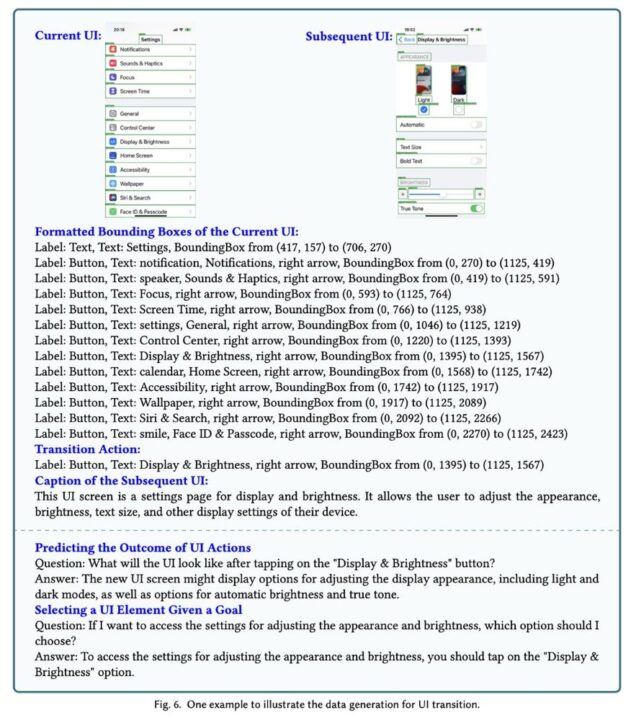

Les chercheurs ont développé un jeu de données synthétiques qui est basé sur quelques exemples. Ce jeu de données comprend des interactions de type questions-réponses, des descriptions détaillées d’écrans, des prédictions de résultats d’actions et même des plans multi-étapes. Par exemple, le modèle peut expliquer « comment écouter le dernier épisode d’un podcast » ou « comment modifier les paramètres de luminosité ».

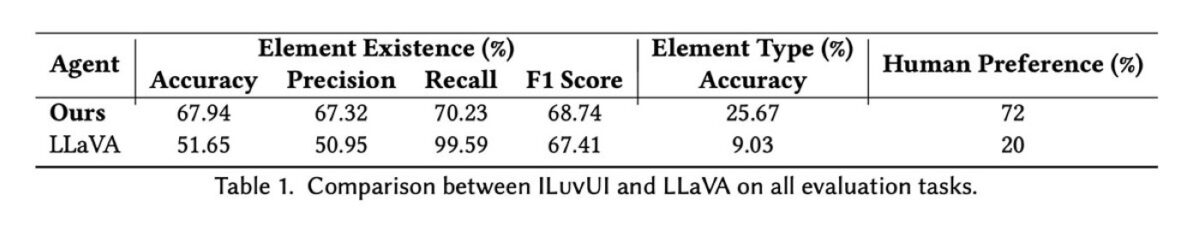

Des performances supérieures confirmées par les tests

Après l’entraînement sur ce jeu de données spécialisé, ILuvUI démontre des performances nettement supérieures à LLaVA dans sa version d’origine. Ces améliorations se vérifient tant dans les benchmarks automatisés que dans les tests de préférence humaine. Cette double validation confirme la pertinence de l’approche adoptée.

ILuvUI présente plusieurs avantages techniques significatifs. Le modèle ne nécessite pas de définir une région d’intérêt spécifique et accepte un prompt textuel en plus de l’image d’interface. Cette flexibilité permet de répondre à des cas d’usage variés, notamment les questions visuelles sur les interfaces.

Les chercheurs d’Apple identifient plusieurs applications potentielles. L’accessibilité représente l’un des domaines les plus prometteurs, où ILuvUI pourrait faciliter la navigation pour les utilisateurs ayant des besoins spécifiques. L’automatisation des tests d’interface constitue également une application directe de cette technologie.

L’équipe reconnaît qu’ILuvUI repose encore sur des composants open source. Cependant, les travaux futurs pourraient intégrer des encodeurs d’images plus performants, une meilleure gestion de la résolution et des formats de sortie compatibles avec les frameworks d’interface existants (comme JSON).

Vers une automatisation plus poussée des interfaces

Cette recherche s’inscrit dans une démarche plus large d’Apple sur l’intelligence artificielle appliquée aux interfaces. Des travaux récents explorent déjà la capacité des modèles d’IA à anticiper les conséquences des actions dans les applications. Cette approche prédictive complète les capacités de compréhension d’ILuvUI.

La combinaison de ces deux approches ouvre des perspectives particulièrement intéressantes. Les utilisateurs dépendant de l’accessibilité pour naviguer sur leurs appareils pourraient bénéficier d’une assistance plus intuitive. De même, l’automatisation des tâches répétitives dans les applications devient plus accessible, permettant au système d’exploitation de gérer de manière autonome les aspects les plus complexes des flux de travail applicatifs.

ILuvUI représente donc une avancée dans la compréhension des interfaces par l’intelligence artificielle. Cette technologie pourrait transformer la façon dont nous interagissons avec nos appareils mobiles, en rendant les interfaces plus accessibles et les tâches plus facilement automatisables. L’approche d’Apple illustre le potentiel de l’IA pour améliorer l’expérience utilisateur mobile.