Pédopornographie : Craig Federighi (Apple) reconnaît une confusion et clarifie

Craig Federighi, responsable d’iOS et macOS, a reconnu qu’Apple n’avait pas très bien communiqué son outil pour lutter contre la pédopornographie. Il tente de clarifier tout cela dans une interview avec le Wall Street Journal.

La clarification de Craig Federighi sur la lutte d’Apple contre la pédopornographie

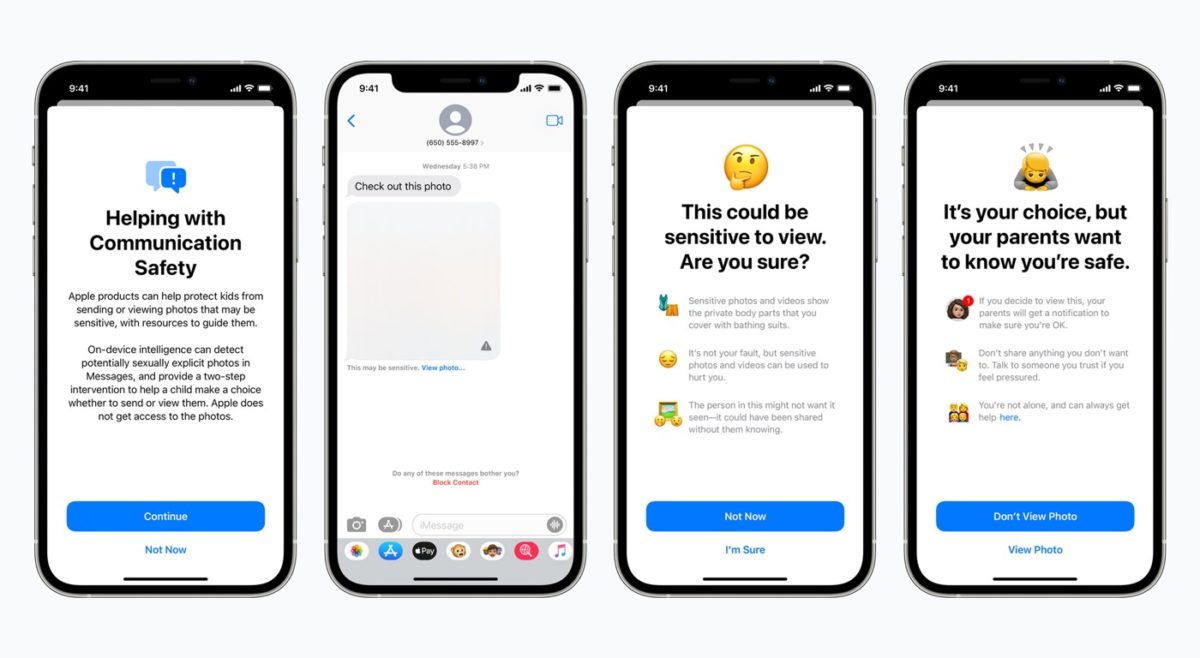

Pour Craig Federighi, Apple aurait dû mieux gérer son annonce pour éviter toute la confusion qui a vu le jour sur Internet. « Il est clair que de nombreux messages ont été mal interprétés. Nous aurions aimé que les choses soient un peu plus claires pour tout le monde, car nous sommes très positifs et convaincus de ce que nous faisons », dit le vice-président d’Apple. Il pense que le vrai problème a été de présenter deux fonctionnalités de lutte contre la pédopornographie en même temps. La première est l’analyse de photos et la seconde est l’analyse de messages pour alerter les mineurs en cas de réception d’une image à caractère sexuel.

« Rétrospectivement, l’introduction de ces deux fonctionnalités en même temps était la recette de ce genre de confusion. En les lançant en même temps, les gens les ont techniquement reliées et ont eu très peur : que se passe-t-il avec mes messages ? La réponse est… rien ne se passe avec vos messages », tente de rassurer Craig Federighi.

Un autre point de taille est l’usage même du système. Un gouvernement peut-il forcer Apple à analyser tel ou tel contenu sur les téléphones ? Le cadre assure que la réponse est non. Cela s’explique par « plusieurs niveaux d’auditabilité ».

Des informations complémentaires sur le fonctionnement

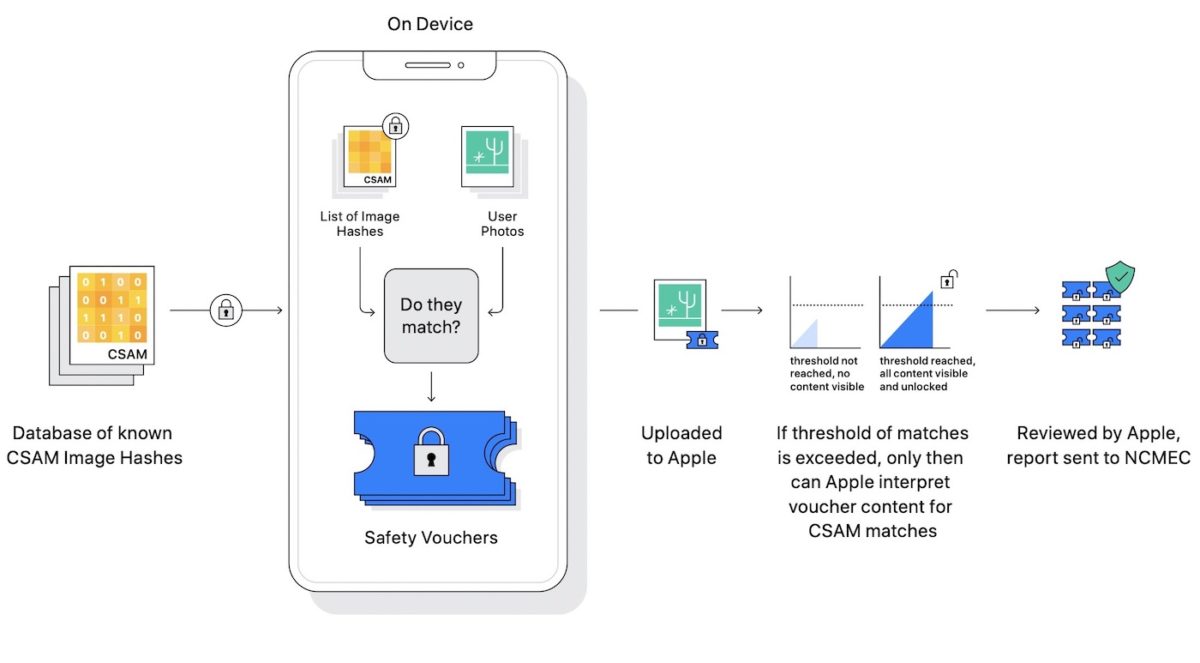

De nouveaux détails sont également partagés sur le système de détection de photos avec de l’abus sexuel sur les enfants. Voici ce que dit Craig Federighi :

Si et seulement si vous atteignez un seuil de quelque chose de l’ordre de 30 photos pédopornographiques connues qui correspondent, c’est seulement à ce moment-là qu’Apple sait quelque chose sur votre compte, et à ce moment-là, il n’est au courant que pour ces photos, et non les autres. Il ne s’agit pas de faire une analyse pour savoir si vous avez une photo de votre enfant dans la baignoire. Ou, d’ailleurs, est-ce que vous aviez une photo pornographique de n’importe quelle autre sorte ? Il s’agit littéralement d’une correspondance sur les empreintes digitales exactes d’images pédopornographiques spécifiques connues.

Pour rappel, Apple va utiliser le hash des photos pour comparer avec celles d’une base de données regroupant des images pédopornographiques. Si un hash correspond, alors Apple est alerté.

Le système de vérification se fait directement sur l’iPhone et non sur les serveurs d’iCloud. Craig Federighi y voit un certain intérêt :

Comme c’est sur le téléphone, les chercheurs en sécurité sont constamment en mesure d’introspecter ce qui se passe dans le logiciel du téléphone d’Apple. Ainsi, si des modifications étaient apportées pour étendre le champ d’application d’une manière ou d’une autre – d’une manière que nous nous étions engagés à ne pas faire – il y a une possibilité de vérification, ils peuvent repérer ce qui se passe.

Pas de base de données compromise

Enfin, le cadre fait savoir que la base de données ne peut pas être compromise avec des images politiques ou autre. Cela s’explique par le fait que les images de la base de données viennent de plusieurs organisations de protection de l’enfance, dont au moins deux qui sont dans des juridictions distinctes. Ces organisations pourront faire des vérifications, ainsi qu’un contrôleur indépendant.

Tout cela sera en place à partir d’iOS 15, d’abord aux États-Unis. Le lancement dans les autres pays aura lieu dans les mois qui suivront. En attendant, des chercheurs en sécurité critiquent le système. Il en va de même pour le lanceur d’alerte Edward Snowen et l’ONG Electronic Frontier Foundation (EFF), qui parle d’une porte dérobée (backdoor) sur iOS. Ce matin, des employés Apple ont exprimé leurs inquiétudes sur le système.

🥳🥳🥳

Des réserves demeurent quand même. Ce système va allouer du stockage de l’appareil, quand bien même ce logiciel ne cible pas les images politiques etc, rien n’empêche à terme de le faire sous le coup d’une loi etc. Je reste inquiet sur ce genre d’outil. Mais la clarification était tout de même bienvenue

on peu le clarifier comme on veut cela reste une Backdoor

Et c’est extrêmement gênant …

Ils ont longtemps critiquer les app qui en avait genre Whatsapp et autres et eux s y mettent …

merci les longue pubs inutiles vantant la confidentialité et le respect de la vie privée.

« Faites ce que je dis mais ne faites pas ce que je fais »

Les enflures, ils ont contrebalancé le fait que nos phones vont être analysés avec la sécurité des nos gosses.

Ils font TOUS ça. Ils prennent toujours les enfants comme exemple (ils = la société) pour amadouer tout le monde et faire de la politique populaire, classique. Ça joue sur l’empathie.

Donc si t’est pedo, tu va travailler chez Apple pour construire et updater la base de donnée, pour la comparaison.

Mais ?

C’est quand même dommage de commenter un article sans l’avoir lu.

Si tu l’avais fait, tu aurais tout de suite eu ta réponse comme quoi la base de données n’est pas gérée par Apple.

Mais c’est tellement mieux de faire le reac et poster tout de suite un commentaire faux qui va générer encore plus d’incompréhension et de parano par rapport aux annonces 👏

« L’enfer est pavé de bonne intention »

Comment sa me soûl toujours a vouloir avoir raison cet pomme ce un non respect de la vie privé ce tout

Le menteuuuur….

Non je te rassure, je n’ai pas fait de confusion Craig, j’ai très bien compris :)

Les haters n’ont pas d’enfants ! Quand vous en aurez vous comprendrez. Si vous aviez connu la dictature vous seriez vraiment ce que c’est l’atteinte à la vie privée ! et quand vous demande d’accepter des cookies à chaque page internet ça ne vous dérange pas ! Bande d’hypocrites !

+1 pour les cookies ! Le truc qui gave tous le monde et qui sert a rien, voté par des demeurés qui ne savent même pas ce qu’est un traitement de texte, en se grattant le ventre !

Alors, une petite précision : on entre rarement en dictature du jour au lendemain… Et une règle de base : il ne faut jamais sacrifier des libertés contre de la sécurité, et même si ce n’est que « provisoire » parce qu’une liberté perdue ne se retrouve jamais sans verser de sang !

Pas tort… sauf pour liberté/sécurité… ne SURTOUT pas tout mélanger (ce que se fait un malin plaisir de faire Apple… )

Sans oublier ceux qui autorisent sans réfléchir l’accès total à leurs galeries photos à différentes applications tel que Facebook, Snapchat, Instagram, etc… et qui ensuite s’inquiètent pour ce que fait Apple dans cet article…

Les photos envoyées par mail avec une adresse iCloud était déjà comparées avec le contenu CSAM. Ça qui a donné lieu à + de 250 détections l’année dernière (en comparaison Facebook c’est + de 20 millions/an)

CA c’est une info. Merci

Craig vendrait sa mère pour vendre Apple…

Sous forme d’éthique, ils ont de moins en moins de déontologie à Apple… tout (petit à petit) pour le traçage constant de tous!!!

Mais l’idée de départ est très bonne, la pedophilie est un acte immonde, mais idée très mal proposée et dangereuse. Même si certains états utilisent déjà cette technologie sans conditions…

Et si au lieu de critiquer, s’opposer direct en bloc à une chose dont on ne sait que ce qu’on a pu en lire dans des articles qui survolent de très haut le sujet, d’en tirer des conclusions hâtives ( se faire des films ) sur ce que ça va être, on se disait « ok mais on exige des gardes fous, on met des barrières ». Bref encadrer pour faire progresser dans le bon sens au lieu de tout rejeter et au final ne rien faire…

De ce que je lis dans les commentaires, il me semble au final que l’on a plus peur de la dérive d’utilisation que de l’outil en lui-même, est ce pour autant que l’outil est mauvais ?

Et parenthèse, de ce que j’ai pu comprendre en me documentant, le hash n’est pas l’image elle même, donc il n’y a pas de détention de l’image si l’on a que le hash, vu qu’à partir du hash l’opération inverse pour revenir à l’image est de l’ordre de l’impossible… le hash est comparé au hash de l’image de l’utilisateur.

Mais je ne suis pas expert dans le domaine je tente juste de parler en sachant de quoi je parle 😉

Qui ici peut affirmé qu’un telle système mis en place pour sois disant repéré de telle photos ? n’est pas le début d’une surveillance étatique, et qu’il ne l’utiliseront pas pour autre chose ? (pour le bien commun), en sachant que même les employés de la firme se pose des questions, a lire les commentaires (de moi je sais et tu ne connait rien, cela reste a ce posé des questions sur ceux qui pense savoir), même les employés de la pomme, les chercheur en sécurité ainsi que les lanceur l’alerte sont intrigué et inquiet de savoir qu’un t’elle système de surveillance sera mis en place, cela ne vous met pas la puce a l’oreille, ou le faite d’entendre des arguments a endormir la moitié de la planète suffit a convaincre les amoureuses de compote de Po… ?! … ;)

Apple paie des années de marketing hypocrite, à flatter la sottise égocentrique des clients prétendant à l’impunité au nom de « la protection de la vie privée ». S’ils avaient été un peu plus courageux dés le départ, ils ne rameraient pas à ce point (alors qu’ils ont justement inventé un super moyen d’empêcher la pédopornographie sa

Exact

bla bla bla et encore du bla bla, ils prennent vraiment les gents pour des C… ;)

Disons que dans ton cas ça ne serait pas illogique

Ou la je ne savais pas que j’avais une fane :)

On en est à un point où je ne lis même pas l’article car je sais que c’est du BS de PR.