Pédopornographie : Apple est poursuivi pour avoir abandonné son système de détection

Apple fait face à une plainte déposée par une femme de 27 ans, qui l’accuse de ne pas avoir mis en place son système de détection des contenus pédopornographiques (CSAM) sur iCloud. Le projet avait été annoncé en 2021, avant d’être abandonné un an plus tard.

Le système en question devait scanner les photos iCloud des utilisateurs pour détecter des images d’abus sexuels sur des enfants, en utilisant des signatures numériques de groupes comme le National Center for Missing and Exploited Children.

L’attaque juridique repose sur l’argument que la décision d’Apple de ne pas mettre en place cette technologie a permis la diffusion continue de contenus traumatisants pour les victimes. Selon la plaignante, une proche l’a agressée étant enfant et a partagé des photos d’elle, dont elle continue de recevoir des notifications quotidiennes des forces de l’ordre pour des arrestations liées à la possession de ces images.

L’avocat James Marsh, impliqué dans cette affaire, estime que 2 680 victimes pourraient avoir droit à une compensation. 1,2 milliard de dollars de dommages et intérêts sont réclamés à Apple.

Apple se défend sur le sujet

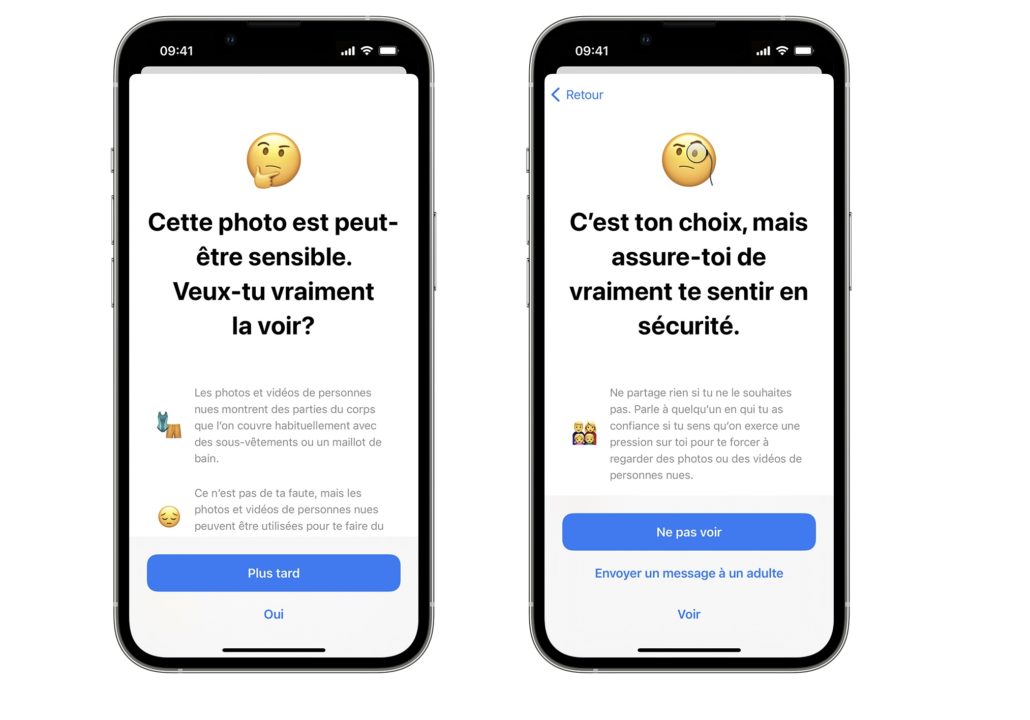

« Les contenus pédopornographiques sont odieux et nous nous engageons à lutter contre les méthodes utilisées par les prédateurs pour mettre les enfants en danger. Nous innovons activement et de toute urgence pour lutter contre ces crimes sans compromettre la sécurité et la vie privée de tous nos utilisateurs », a assuré un porte-parole d’Apple au New York Times. Il note notamment que des outils existent au niveau de l’application Messages pour avertir les enfants de la présence de contenus dénudés. Les utilisateurs peuvent signaler à Apple les contenus préjudiciables.

Apple avait initialement annoncé que ce système aiderait à protéger les enfants, mais a abandonné le projet face aux critiques de défenseurs de la vie privée et de la sécurité. Ces derniers craignaient que le dispositif serve de porte dérobée pour la surveillance gouvernementale. L’entreprise assure cependant qu’elle continue de travailler sur des solutions pour combattre ces crimes sans compromettre la sécurité et la confidentialité de ses utilisateurs.

Ce n’est pas la première fois qu’Apple est critiquée pour sa gestion du CSAM. En août dernier, une plainte similaire avait été déposée par une enfant de 9 ans et son tuteur. L’affaire soulève de nouveau des questions sur l’équilibre entre sécurité, vie privée et lutte contre les abus en ligne.

Je comprends bien la gravité de la chose mais faud il être obligé d’être espionné pour autant ?

+1

bcq de lobbie sont de la M… idem pour certaine association cela a toujours été

Et c est malheureux ….

C’était sensé tourné en local il me semble

Si c’est sur iCloud ça tourne certainement pas en local

Je trouve vraiment dommage qu’ils aient dû se rétracter. J’aurais été prêt à avoir quelques faux positifs (en plus anonymes) pour une telle cause. La techno derrière avait l’air très solide.

a été « forcé » d’arrêter le développement de cette technologie par le tollé que cette annonce a provoqué !